クロールバジェットとは?

クロールバジェットとは、検索エンジンのボットがあなたのウェブサイトをクロールし、そのページをインデックスするために割り当てる時間とリソースの量です。

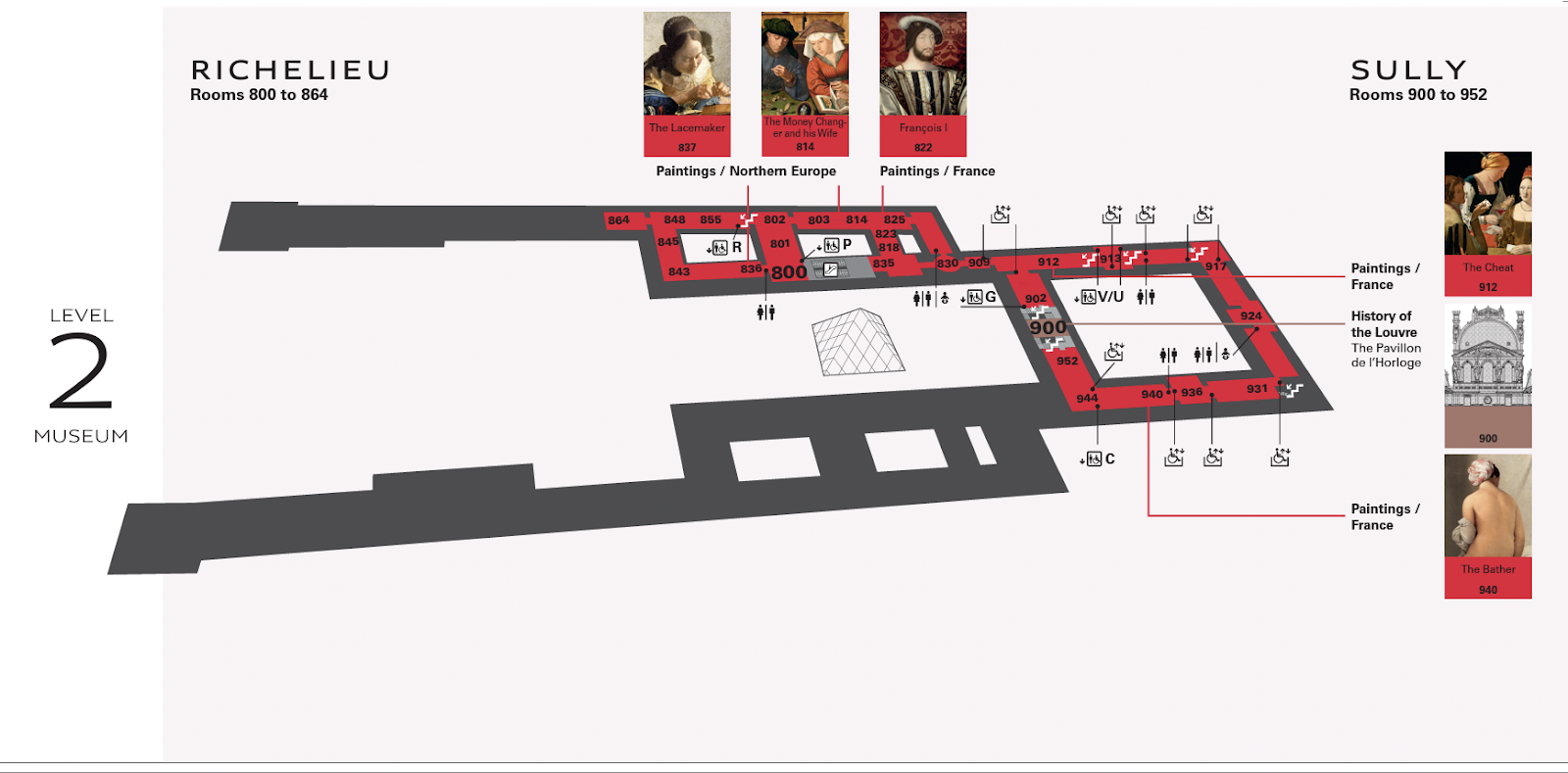

ルーブル美術館には、何百もの展示品が数フロアにわたって展示されている。

地図がなければ、本当に見たかったアートを見逃すことになりかねない。

あなたが手にしている地図を作るには、誰かが各部屋を歩き回り、どの絵画がそこに掲載されているかをマークしなければならない。

この比喩では、ルーブル美術館のマップメーカーは、ウェブサイトをクロールするグーグルボットのようなものだ。

ルーブル美術館内を常に走り回っている地図職人のチームは、観客の体験を鈍らせてしまうだろう。

ボットが常にあなたのウェブサイトをクロールしていると、ウェブサイトの速度が遅くなるのと似ている。

つまり、Googlebotがあなたのウェブサイトをクロールする頻度を知る必要があるのと同じように、マップメーカーはマップを更新する時間を設定する必要があるのだ。

クロール予算はSEOに影響するか?

クロールバジェットはテクニカルSEOのランキング要因ではない。

しかし、Googlebotにクロールエラーが発生し、コンテンツを読み込んでインデックスすることができない場合、検索エンジンの結果ページ(SERPs)にあなたのページが表示される可能性は低くなります。

グーグルボットがあなたのサイトを常にクロールしていることも望まない。

ウェブサイトをクロールするために割り当てられた予算を超えると、システムの速度低下やエラーを引き起こす可能性があります。

その結果、ページがインデックスされるのが遅れたり、まったくインデックスされなかったりして、検索順位が下がる可能性がある。

Googleは何百ものシグナルを使って、あなたのページをどこに配置するかを決定します。 クロールは、あなたのページがどこに表示されるかではなく、表示されるかどうかを指示するものであり、質の高いコンテンツとは何の関係もない。

Googleはクロールバジェットをどのように決定するのか?

すべてのウェブサイトは、クロール需要とクロール制限という2つの主要要素によって制御される独自のクロール予算を持っています。

その仕組みと舞台裏を理解することが重要だ。

クロール需要

クロール要求とは、Googleがあなたのウェブサイトをクロールすることをどれだけ望んでいるかを意味する。

この需要には2つの要素、人気と陳腐さが影響する。

人気

Googleは、バックリンクの多いページやトラフィックの多いページを優先する。 つまり、人々があなたのウェブサイトを訪れたり、リンクを張ったりしていれば、Googleのアルゴリズムは、あなたのウェブサイトがより頻繁にクロールされる価値があるというシグナルを受け取ることになる。

特にバックリンクは、Googleがどのページをクロールする価値があるかを判断するのに役立つ。 Googleは、人々があなたのウェブサイトについて話していることに気づけば、その大騒ぎが何であるかを確認するために、そのウェブサイトをもっとクロールしたいと思う。

バックリンクの数だけが重要なのではなく、バックリンクは関連性があり、権威あるソースからのものでなければならない。

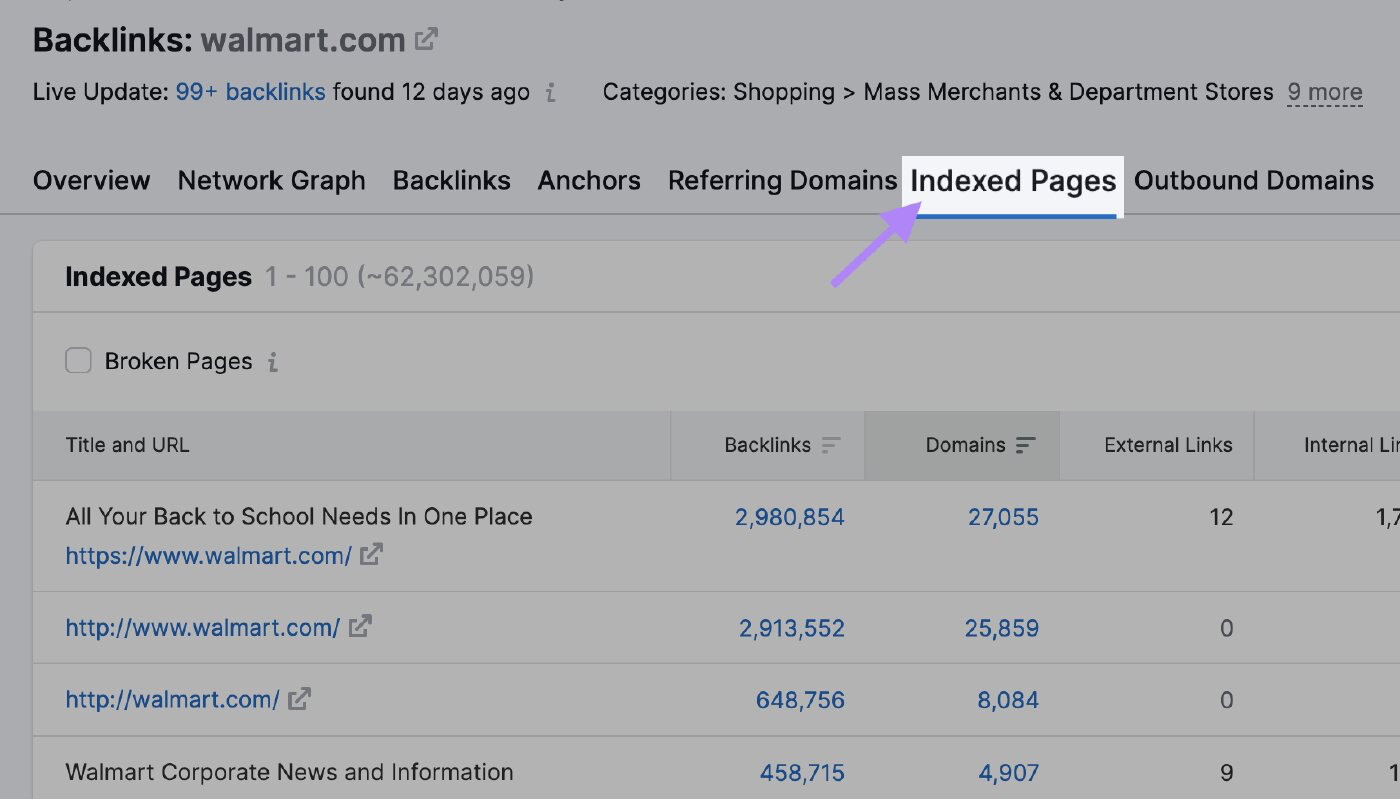

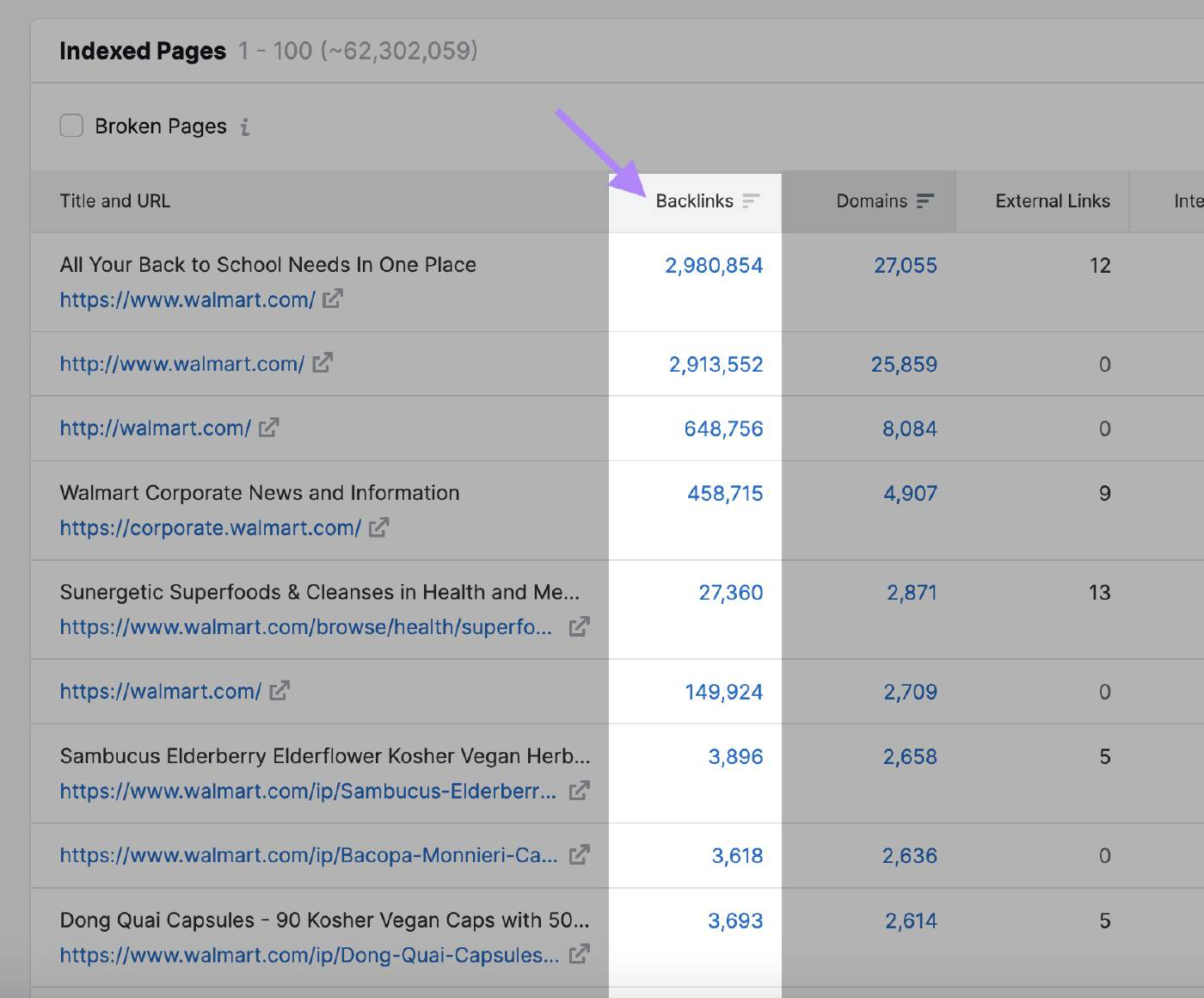

SemrushのBacklink Analyticsツールを使って、どのページが最も多くのバックリンクを集め、Googleの注目を集めるかを見ることができる。 ドメインを入力し、"Indexed Pages"タブをクリックする。

ここでは、バックリンクの多いページを見ることができます:

スタルネス

Googlebotはしばらく更新されていないページをクロールしない。

グーグルは、検索エンジンがウェブサイトを再度クロールする頻度を明らかにしていない。 しかし、アルゴリズムが一般的なサイトの更新に気づいた場合、ボットは一時的にクロールの予算を増やす。

例えば、グーグルボットはニュースサイトを頻繁にクロールする。

この場合、ウェブサイトは高いクロール要求を持っている。

有名な美術品の歴史についてのウェブサイトが、それほど頻繁に更新されていないのと比べてみてほしい。

Googleにクロールの変更を知らせる可能性のあるその他の行動には、以下のようなものがある:

- ドメイン名の変更:ウェブサイトのドメイン名を変更すると、Googleのアルゴリズムは新しいURLを反映させるためにインデックスを更新する必要があります。 ウェブサイトをクロールして変更を理解し、ランキングシグナルを新しいドメインに渡す。

- URL構造の変更:ディレクトリ階層を変更したり、サブドメインを削除・追加したりしてウェブサイトのURL構造を変更した場合、Googleのボットは新しいURLを正しくインデックスするためにページを再クロールする必要がある。

- コンテンツの更新:ページの大部分を書き換えたり、新しいページを追加したり、古くなったコンテンツを削除するなど、ウェブサイトのコンテンツを大幅に更新すると、アルゴリズムの注意を引き、ウェブサイトの再クロールを促す可能性があります。

- XMLサイトマップの送信:XMLサイトマップを更新し、Google Search Consoleに再送信することで、クロールすべき変更があることをGoogleに知らせることができます。 これは、新しいページや更新されたページをGoogleに速やかにインデックスさせたい場合に特に有効だ。

クロール速度制限

クロール速度の制限は、検索結果にコンテンツを表示するために、ボットがサイトにアクセスしてウェブページをダウンロードする速度を決定します。

これは、Googleのクロールがあなたのサーバーに負荷をかけないようにするための方法です。

クロールの制限は、ボットが多すぎるリクエストでウェブサイトを停滞させるのを防ぎ、パフォーマンスの問題を引き起こす可能性があります。

もしあなたのサイトが素早く反応すれば、グーグルは制限を増やす許可を得て、クロールにより多くのリソースを使うことができる。

同様に、Googleがサーバーエラーに遭遇したり、サイトの速度が落ちたりすると、制限値が下がり、Googlebotのクロール回数が減る。

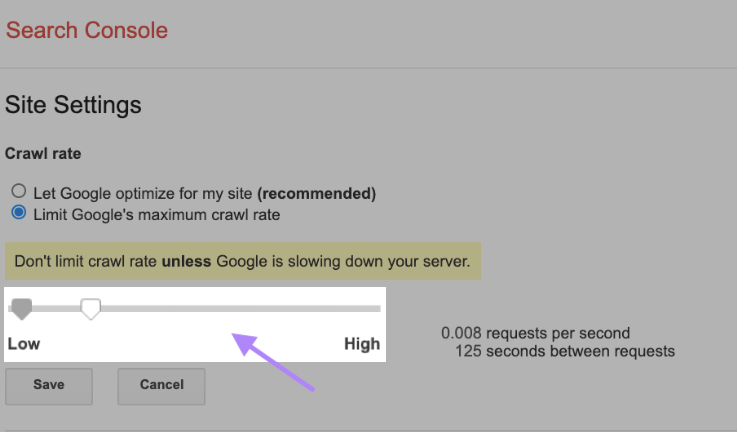

クロール制限を手動で変更することもできるが、この場合は慎重に行うことが重要だ。 Googleは、サーバーの速度が低下していない限り、クロールレートを制限しないことを推奨している。

クロール率を変更するには、Search Consoleのサイト設定に行き、バーを調整します。 調整には通常2日ほどかかる。

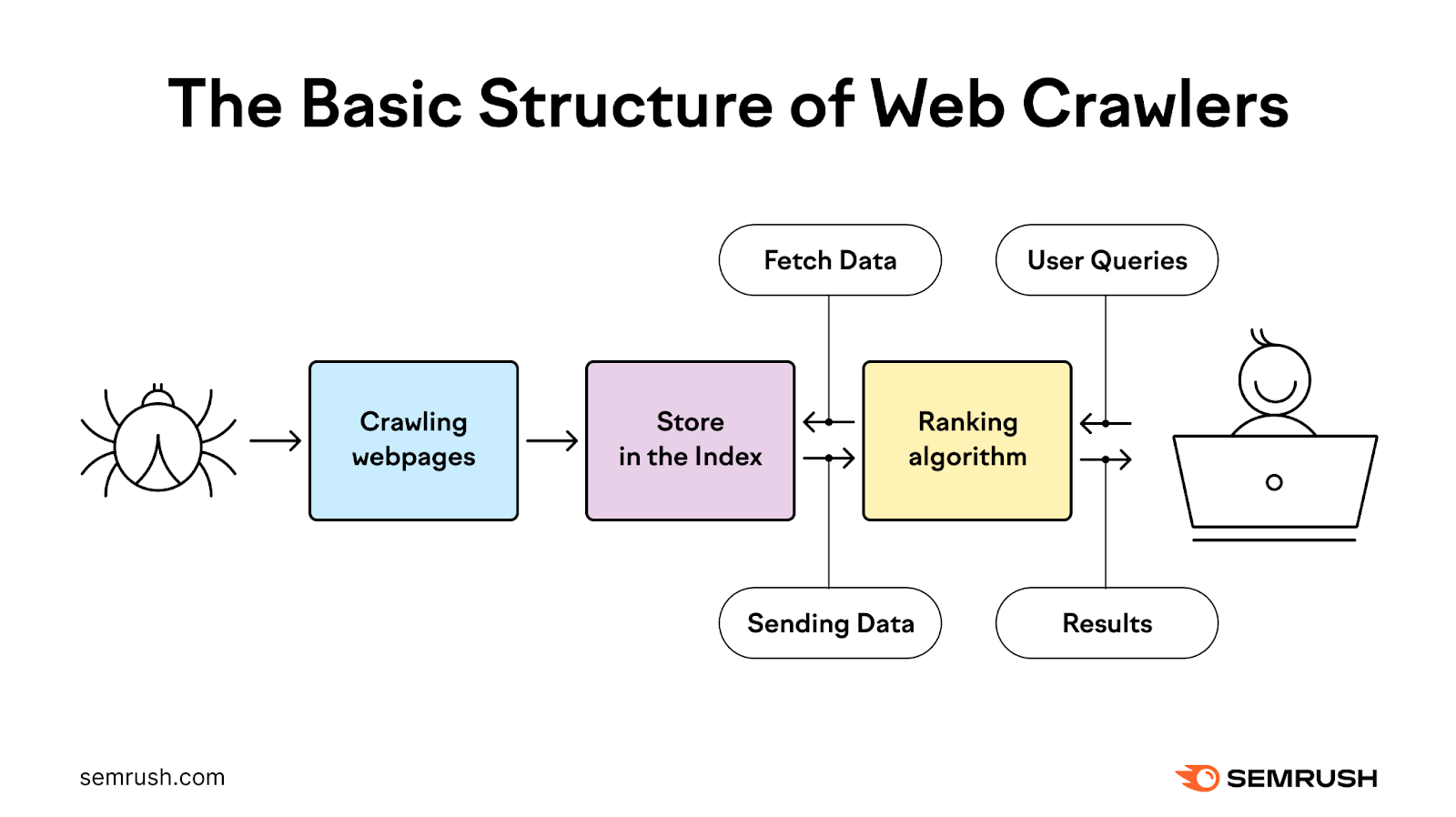

クロールの仕組み

クローリングプロセスは、ボットを使用してウェブページを発見、クロール、分析、インデックス化し、ユーザーに最も関連性の高い高品質の検索結果を提供する。

これは、過去のクロールやサイト所有者が提供するXMLサイトマップからウェブアドレスをリストアップすることから始まる。 そして、グーグルはウェブクローラーを使ってこれらのアドレスを訪問し、情報を読み、ページ上のリンクをたどる。

クローラーは、Googleがすでにリストに入れているページを再訪問し、変更があったかどうかをチェックし、新しいページもクロールする。

このプロセスの間、ボットはクロール要求に基づいて、いつ、何をクロールするかの優先順位を決定する。

そして、クロールに成功したページを処理してグーグルに渡し、検索結果にインデックスさせる。

ほとんどの場合、グーグルは小規模なウェブサイトを効率的にクロールする。

何百万ものURLを持つ大規模なウェブサイトに関しては、Googleはいつ、何をクロールし、どれだけのリソースを割くべきか、優先順位をつける必要がある。

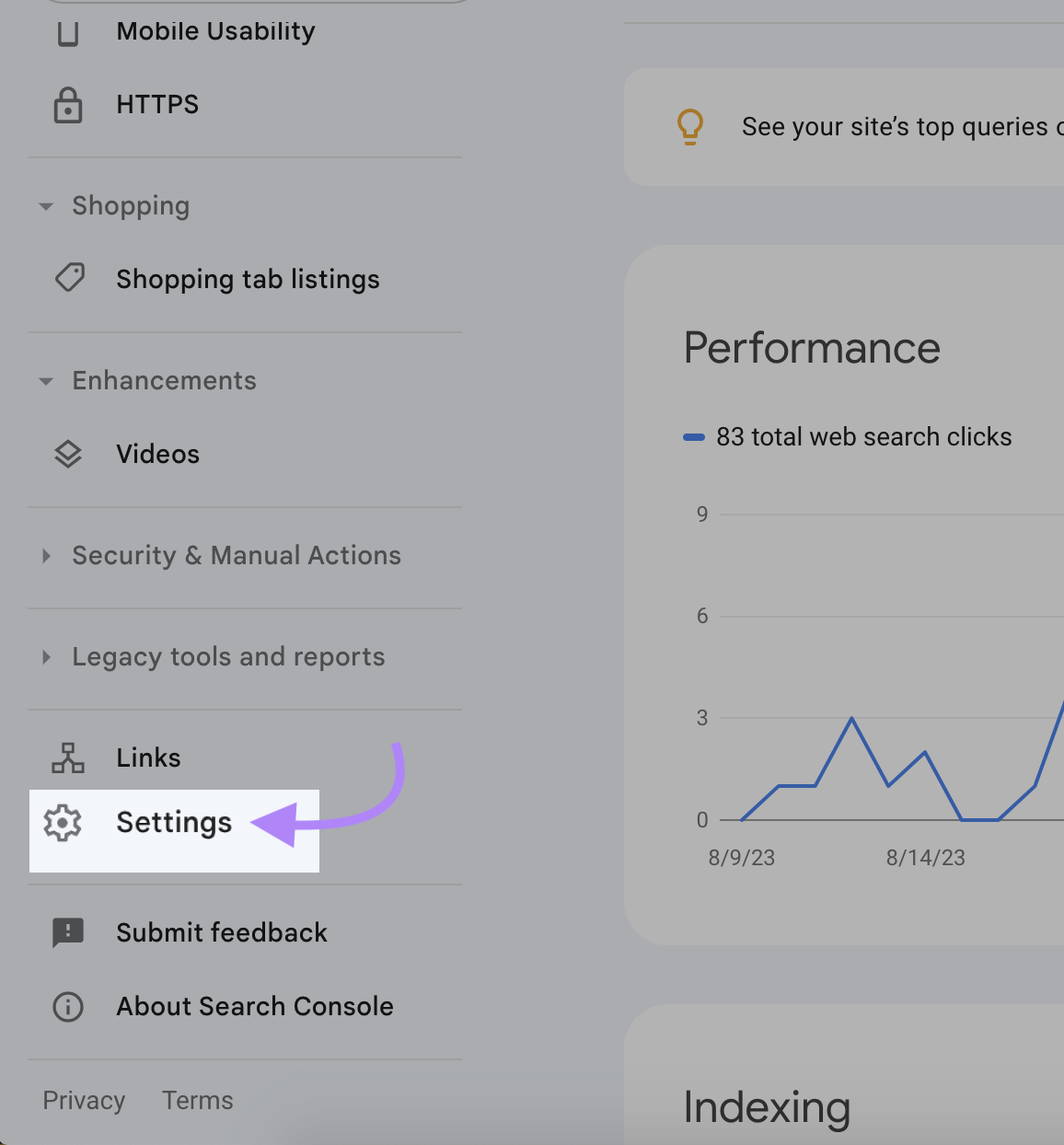

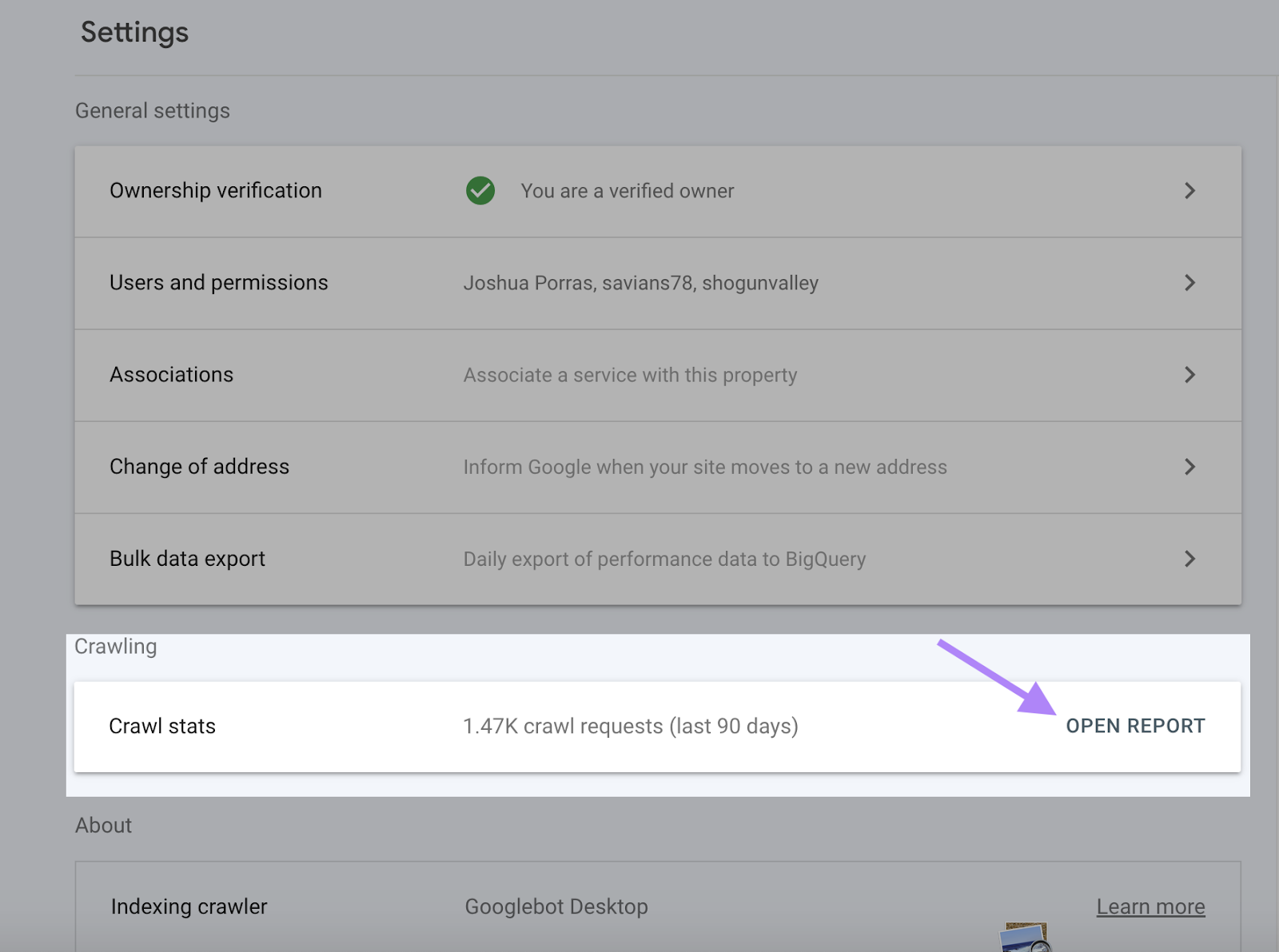

クロール活動の確認方法

Google Search Consoleでは、クロールエラーやクロール率など、クロールアクティビティに関する完全な情報をクロール統計レポートで提供しています。

クロール統計レポートは、Googleがあなたのコンテンツにアクセスし、インデックスできるかどうかを再確認するのに役立ちます。 また、ウェブサイトの可視性が低下する前に、問題を特定して修正することもできます。

クロール統計レポートにアクセスするには、Search Consoleにログインし、"設定"をクリックします。

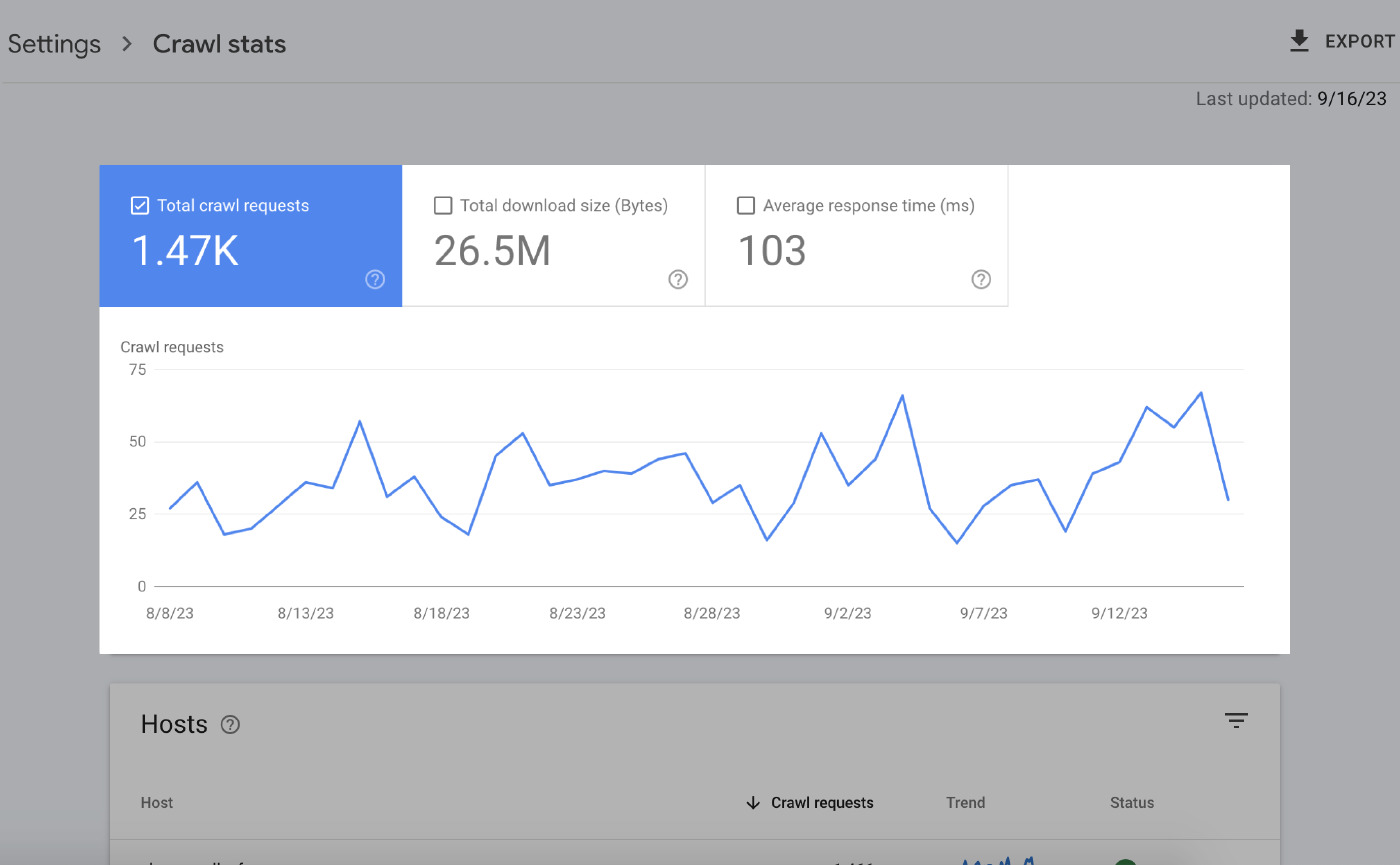

サマリー・ページには多くの情報が掲載されている。 主な要素は以下の通り:

オーバータイムチャート

オーバータイムチャートは、過去90日間のクロールデータをハイライトします。

これが何を意味するのか:

- クロールリクエストの総数:過去90日間にGoogleが行ったクロールリクエストの数。

- 総ダウンロードサイズ:特定の期間にGoogleのクローラーがウェブサイトにアクセスした際にダウンロードしたデータの総量。

- 平均応答時間:ユーザーのブラウザからのリクエストに対して、ウェブサイトのサーバーが応答するのにかかる時間。

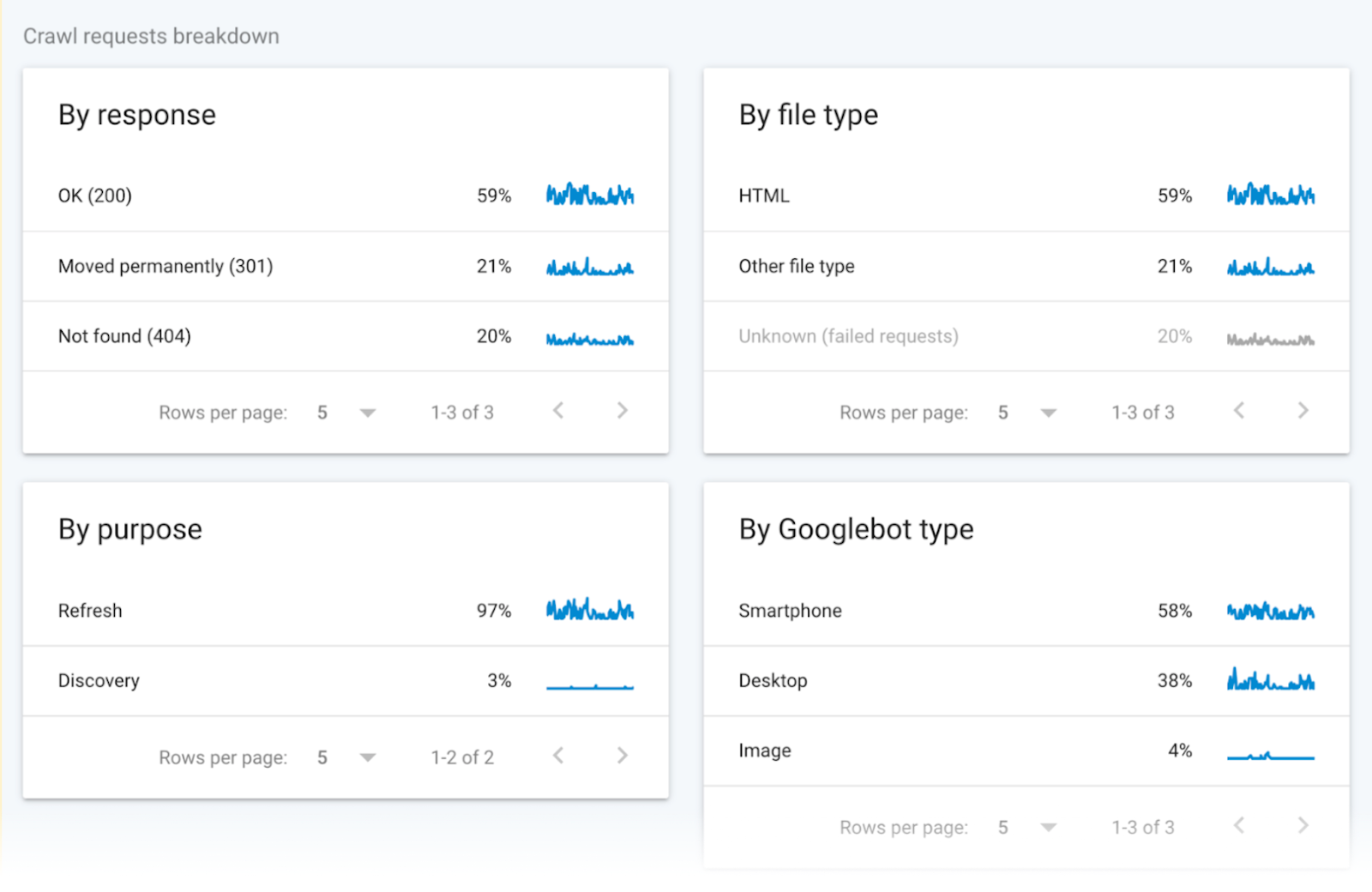

グループ化されたクロール・データ

グループ化されたクロールデータは、クロールリクエストに関する情報を提供する。

このデータは、URLのファイルタイプ、レスポンス、Googlebotのタイプ、リクエストの目的(新しいページの発見または既存ページの更新)に応じて、これらのリクエストを分割している。

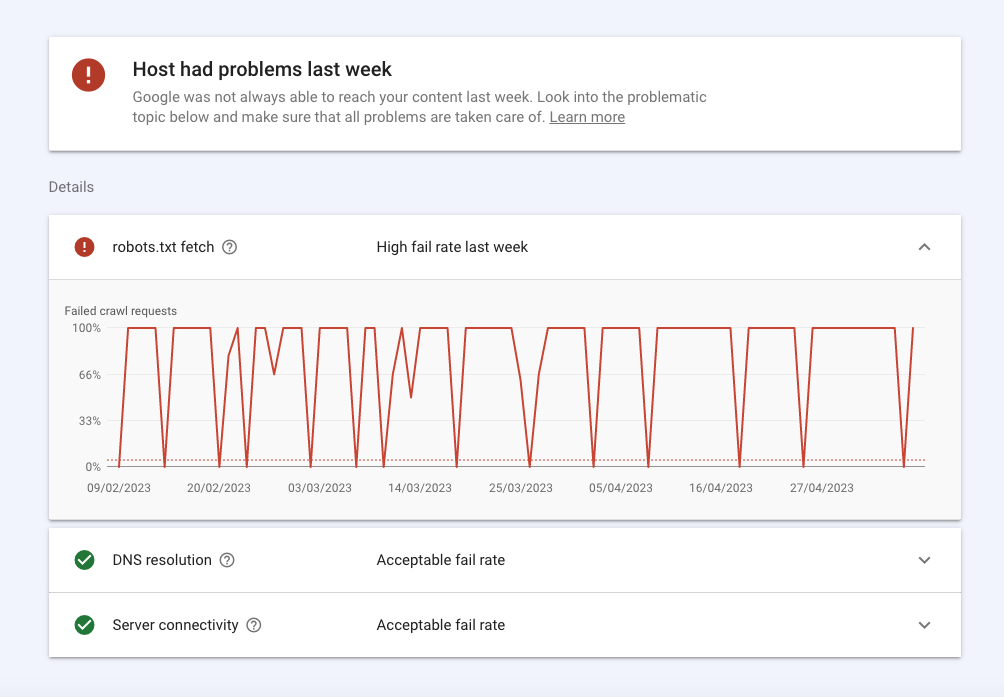

ホストステータス

ホストのステータスは、あなたのサイトの一般的な可用性とGoogleが問題なくアクセスできるかどうかを示します。

内訳はこうだ:

- robots.txtセクションのエラーは、Googleが技術的な理由であなたのサイトをクロールできなかったことを意味します。 Robots.txtフェッチは、ボットがあなたのrobots.txtファイルをクロールしたときに経験した失敗率を教えてくれます。 あなたのサイトはrobots.txtファイルを必要としないが、要求されたときに正常なレスポンス200または404を返さなければならない。 もしGooglebotが503 HTTPステータスのような接続の問題を抱えている場合、あなたのサイトのクロールを停止します。

- DNSリゾリューションは、DNSサーバーがあなたのホスト名を認識しなかったり、クロール中に応答しなかった場合に通知します。 ここで問題が発生した場合は、レジストラに連絡して、サイトが正しく設定され、サーバーがアクティブなインターネット接続を持っていることを確認してください。

- サーバーコネクティビティは、サーバーが応答しなかったり、完全な応答を提供しなかった場合に表示されます。 ここでスパイクや一貫した接続性の問題が発生している場合は、プロバイダーに容量の増加や可用性の問題の解決について相談する必要があるかもしれません。

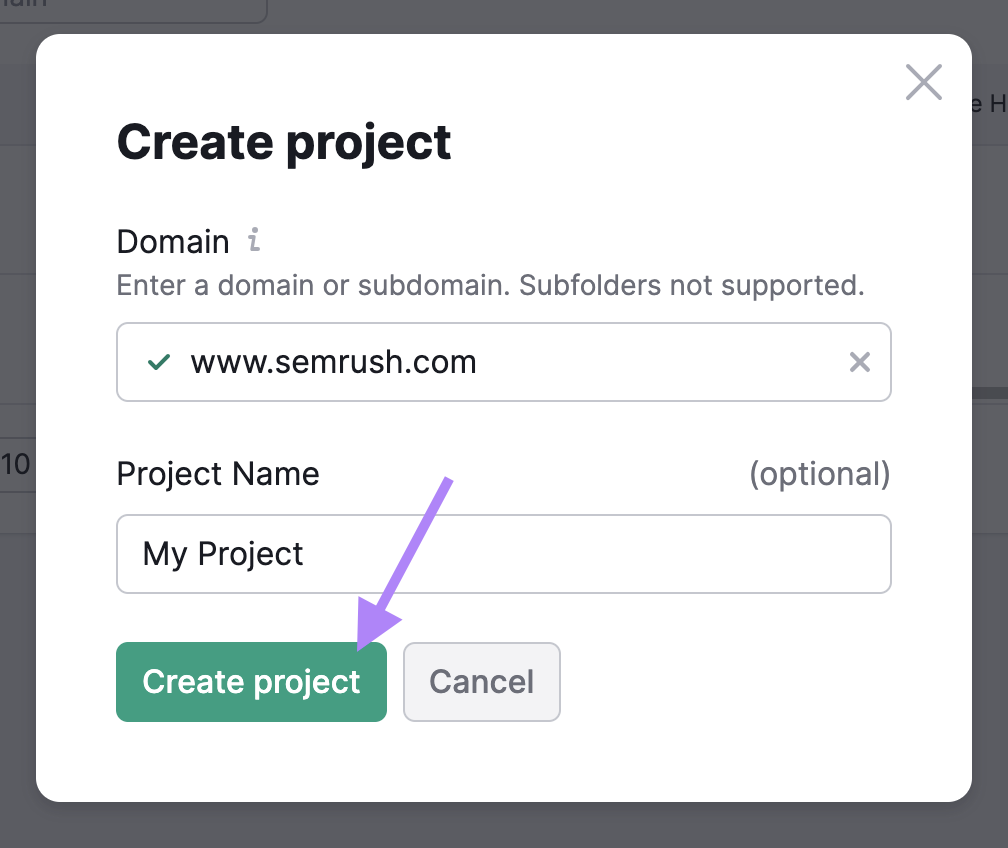

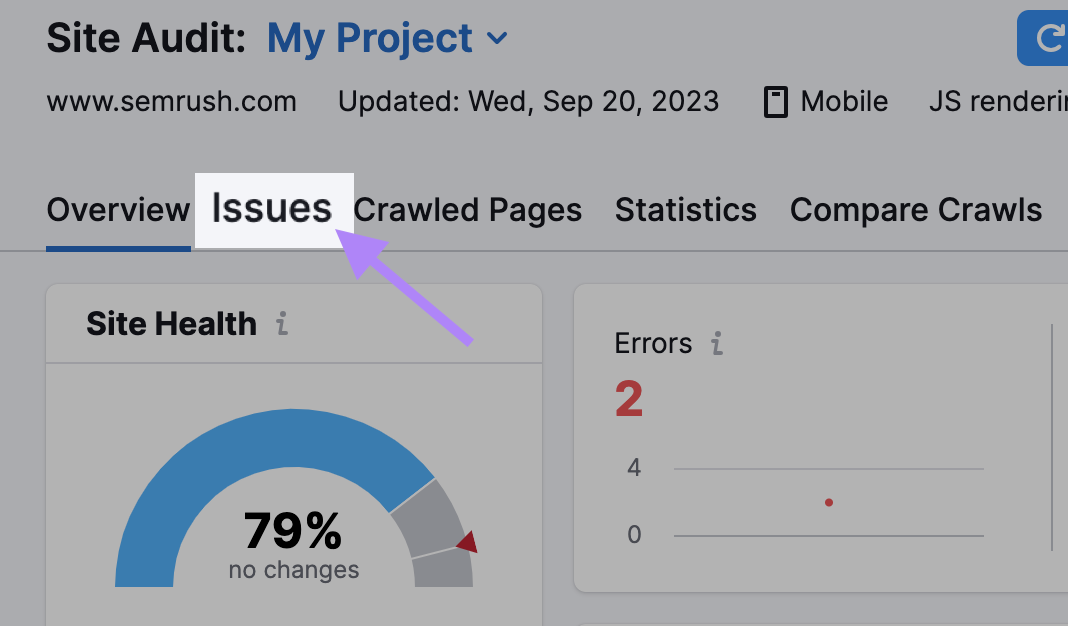

サイト監査でウェブサイトのクローラビリティをチェックする方法

サイト監査ツールを使用して、SemrushBotsにウェブサイトをクロールさせ、健全性をチェックしましょう。

このツールは、重複コンテンツや リンク切れなど 、140以上の問題にフラグを立て、特定して修正することができる。

必要なことは以下の通りだ:

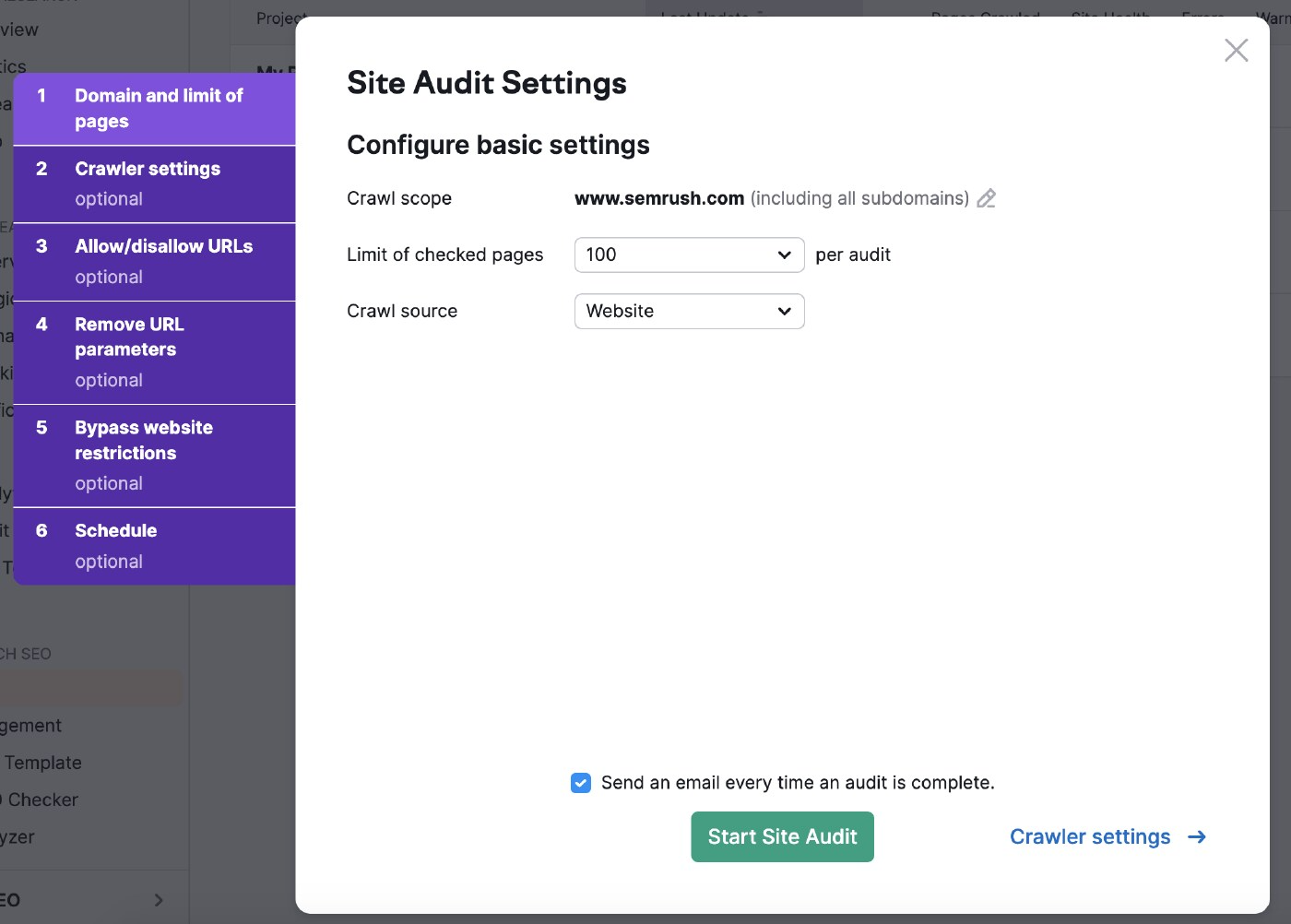

基本設定を確定する

サイト監査ツールにアクセスし、初めての監査であれば新しいプロジェクトを作成します。

次にサイト監査設定を選択します。

クロールスコープで検索範囲を絞り込むことができます。

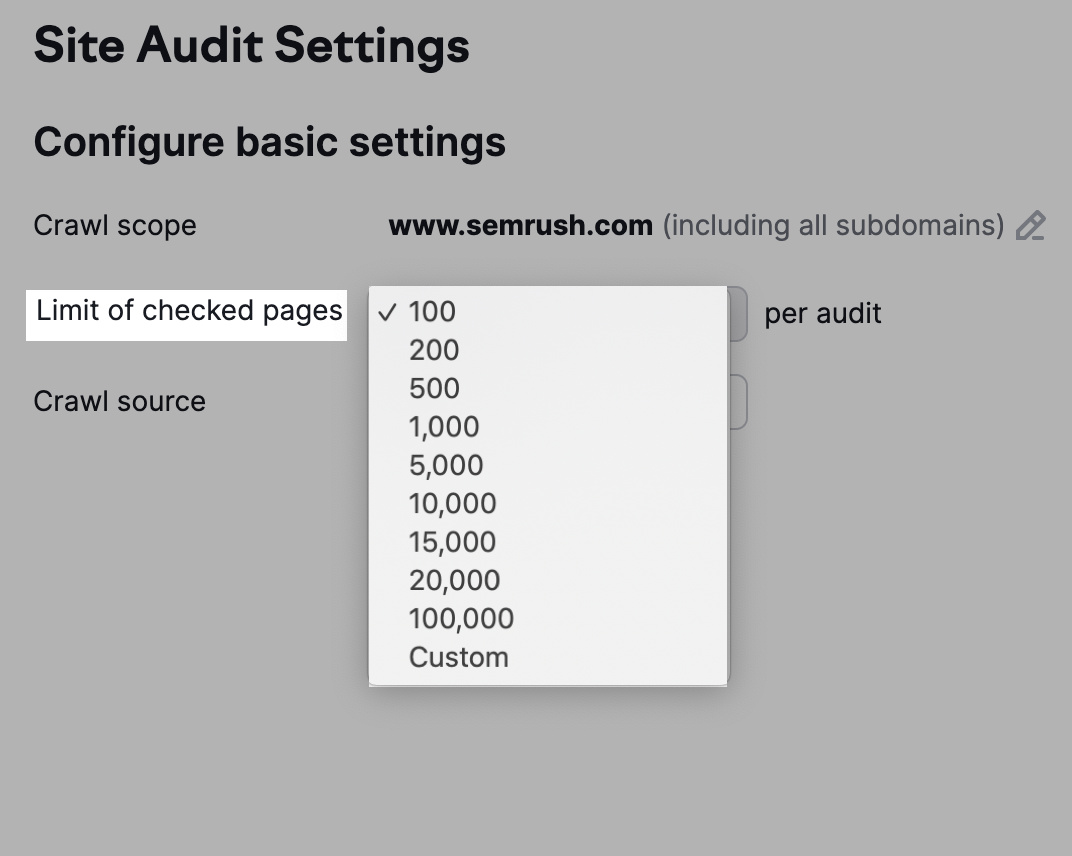

また、サブスクリプション・レベルやウェブサイトの検査頻度に応じて、1回の監査でチェックするURLの数を調整することもできる。

クロールするページ数が多ければ多いほど、知名度が上がる。

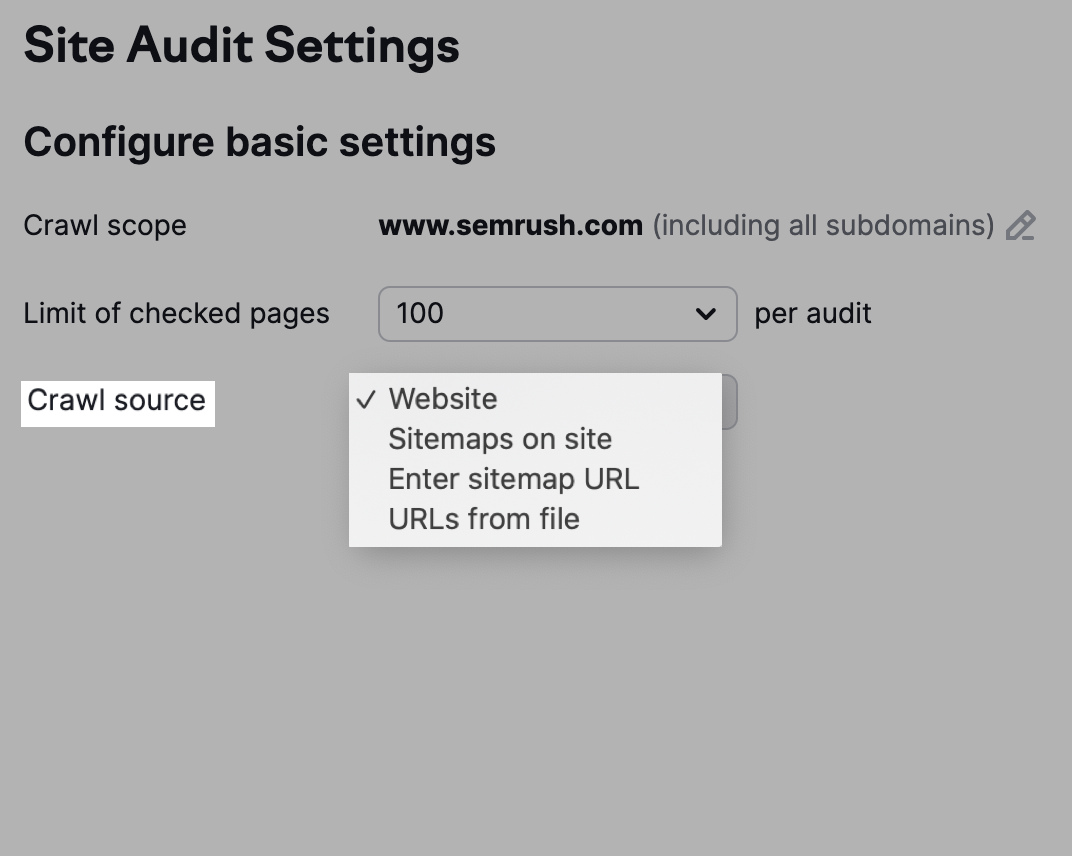

また、クロール元を選択するオプションもある。

一方、「サイトマップ オン サイト」を利用したクロールでは、robots.txtファイルのサイトマップ内のURLが使用されます。

または、「ファイルからのURL」をクリックして、ボットにクロールさせたいページを選択する。

クローラーの設定を調整する

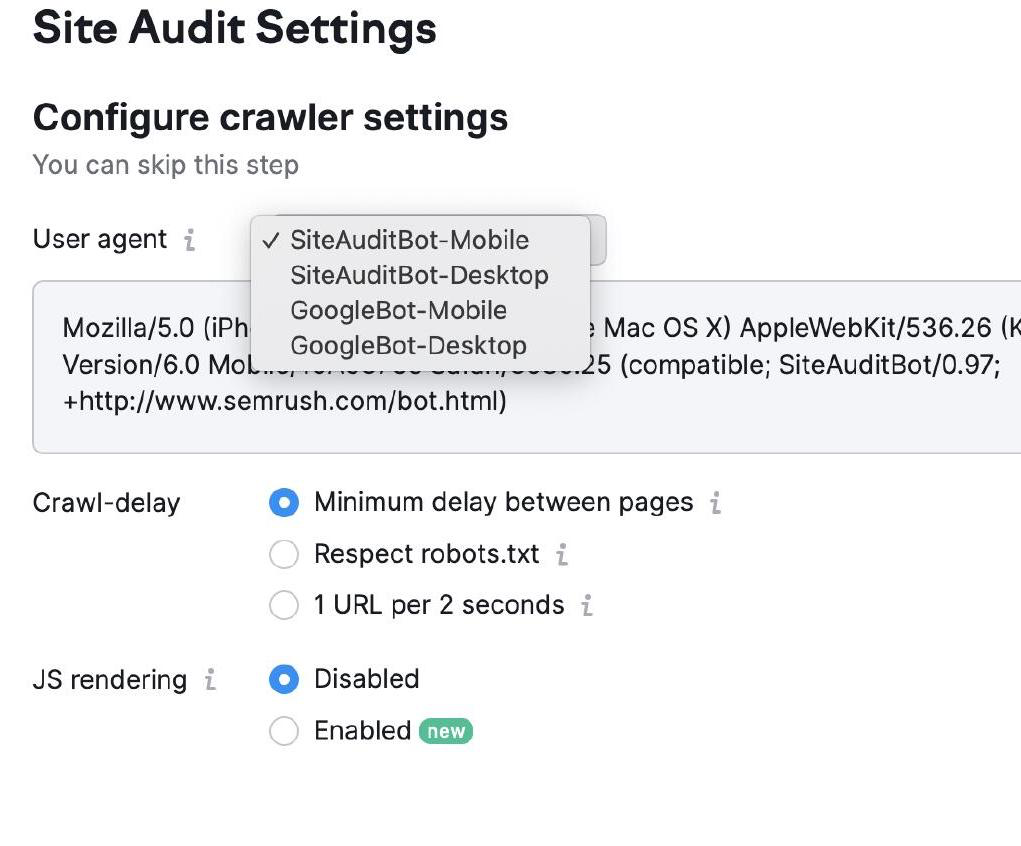

クローラーの設定では、あなたのウェブサイトをクロールするボットの種類を選択することができます。

GooglebotとSemrushBot、モバイル版とデスクトップ版を選択できる。

次にクロールディレイの設定を選択する。 ボットは「最小遅延」で通常の速度でクロールし、「2秒に1URL」の設定でユーザー体験を優先する。

最後に、該当するファイルがあり、特定のクロール遅延が必要な場合は、「robots.txtを尊重する」を選択します。

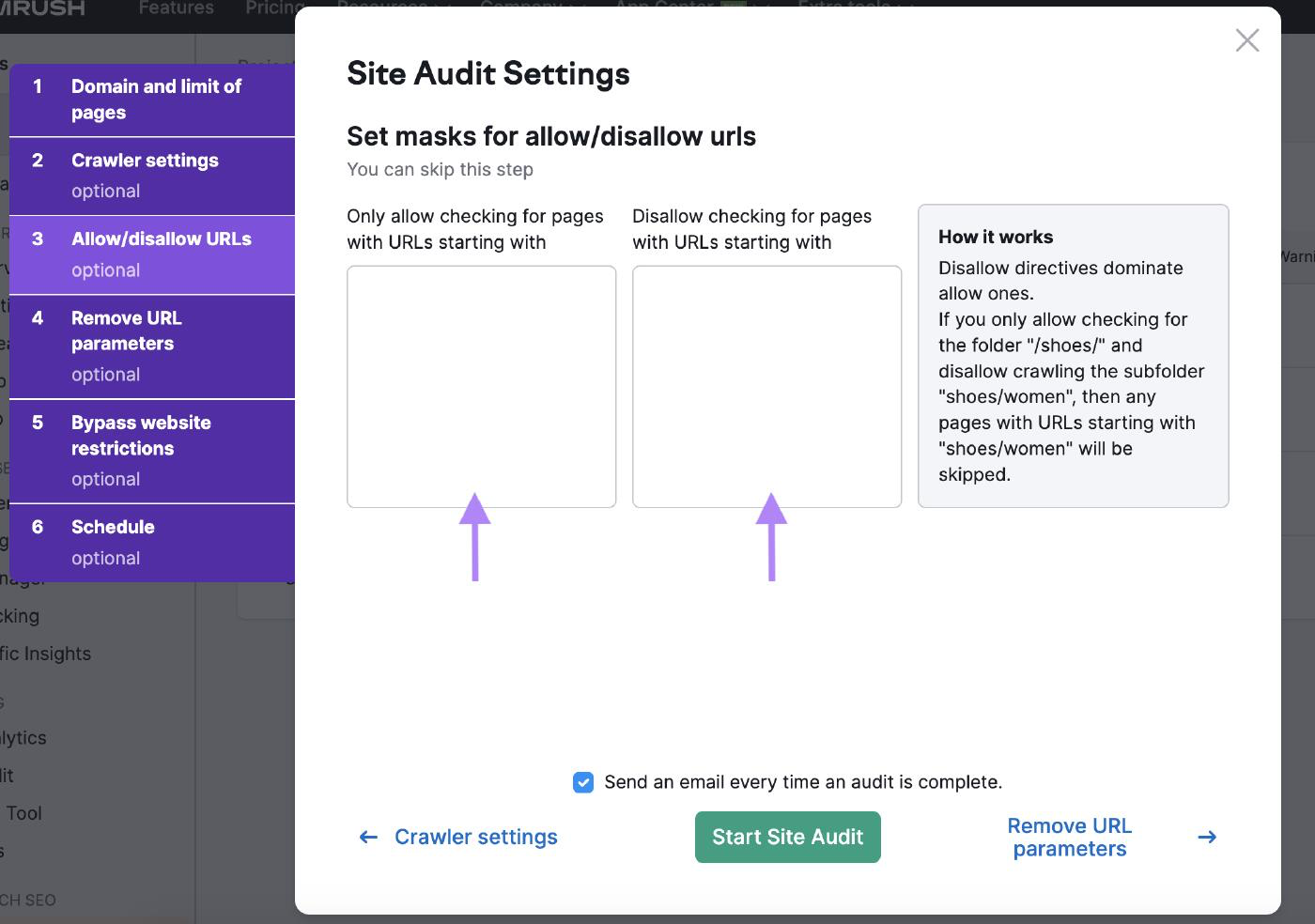

URLの許可/不許可

対応するボックスにURLを入力することで、許可/不許可のURL設定でサイト監査をカスタマイズできます。

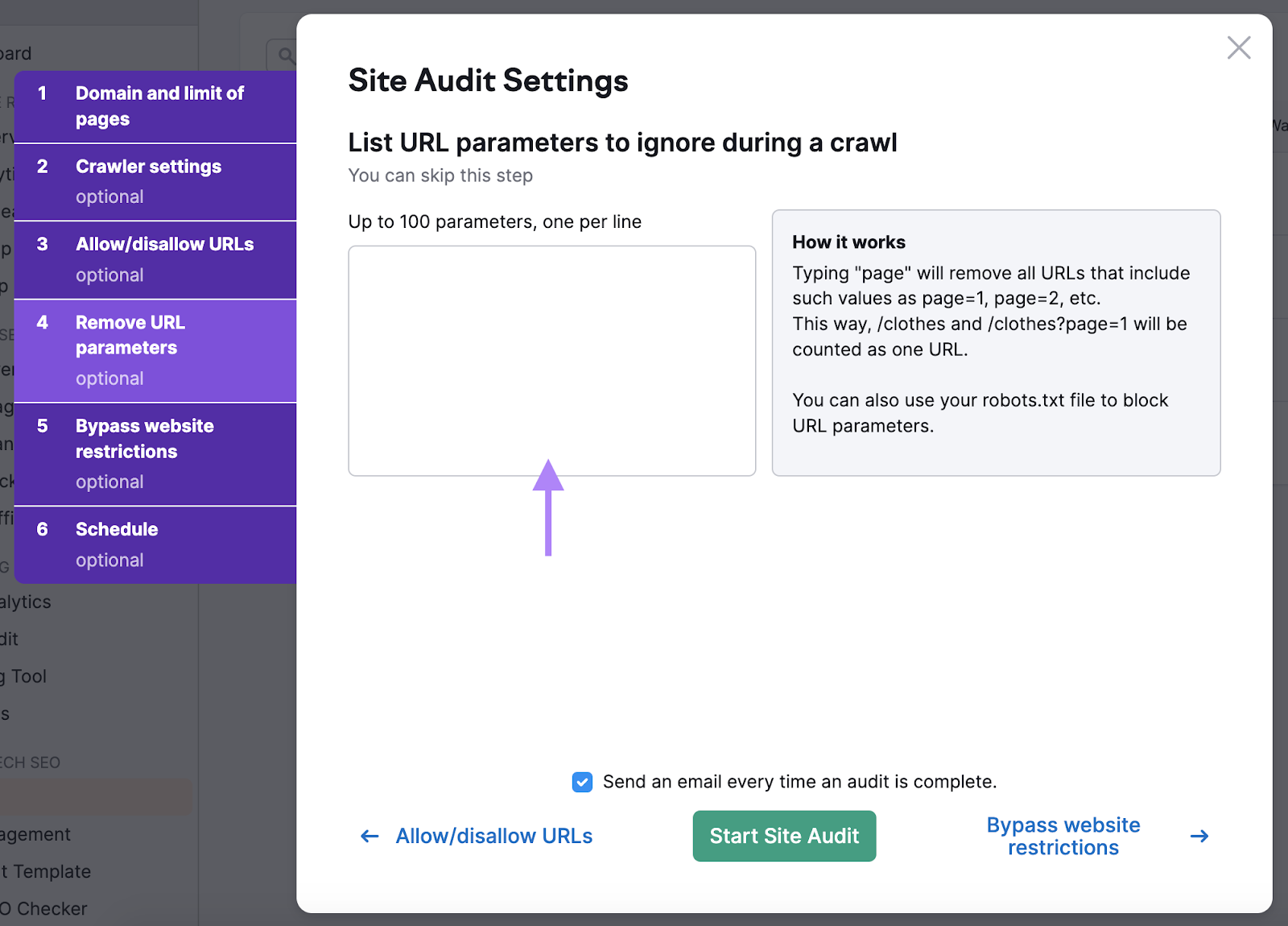

URLパラメータの削除

削除 URLパラメータこれにより、ボットが同じページを2回クロールしてクロール予算を無駄にすることがなくなります。

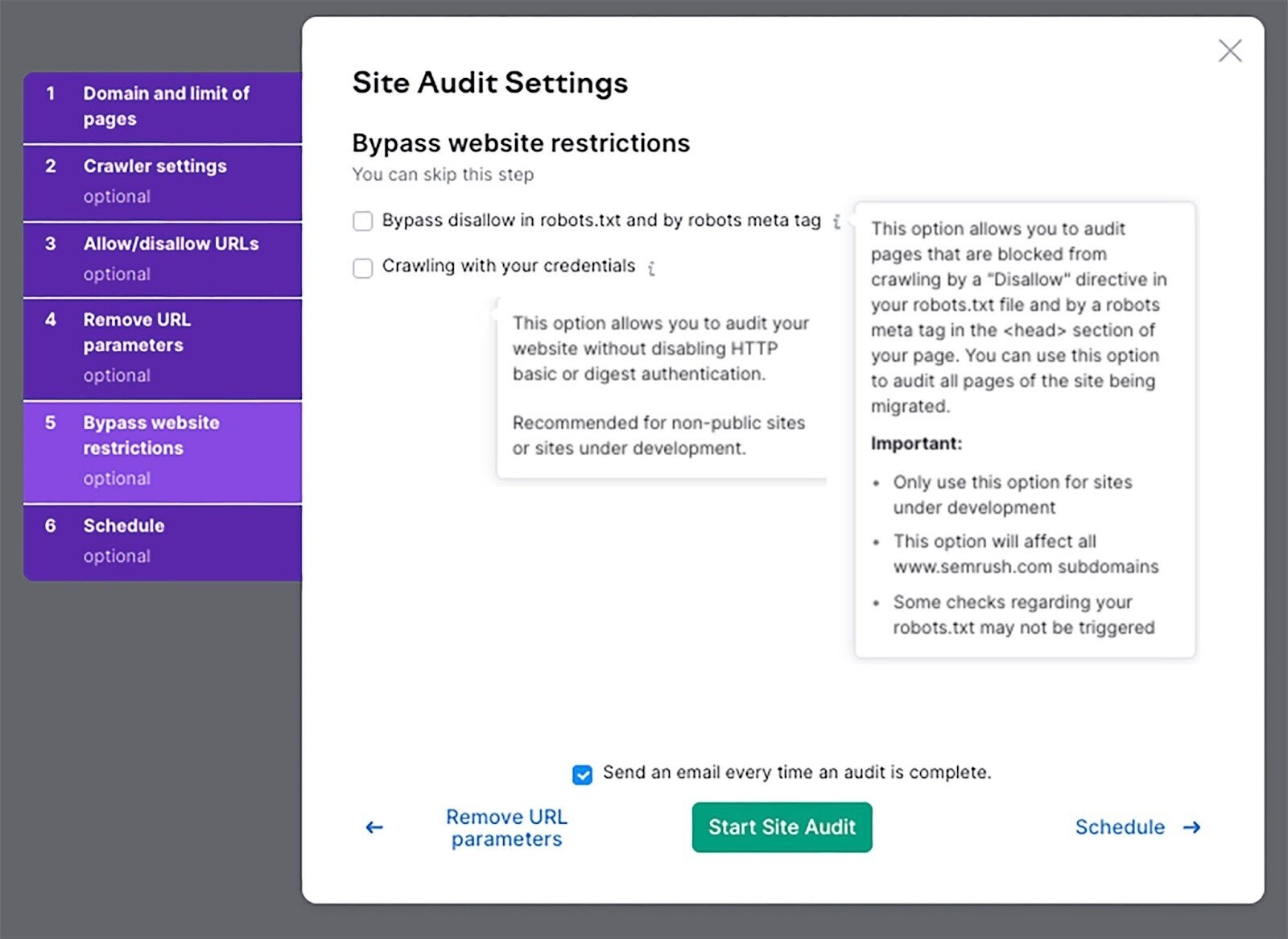

ウェブサイトの制限を回避する

ウェブサイトがまだ開発中の場合は、この設定を使って監査を実行してください。

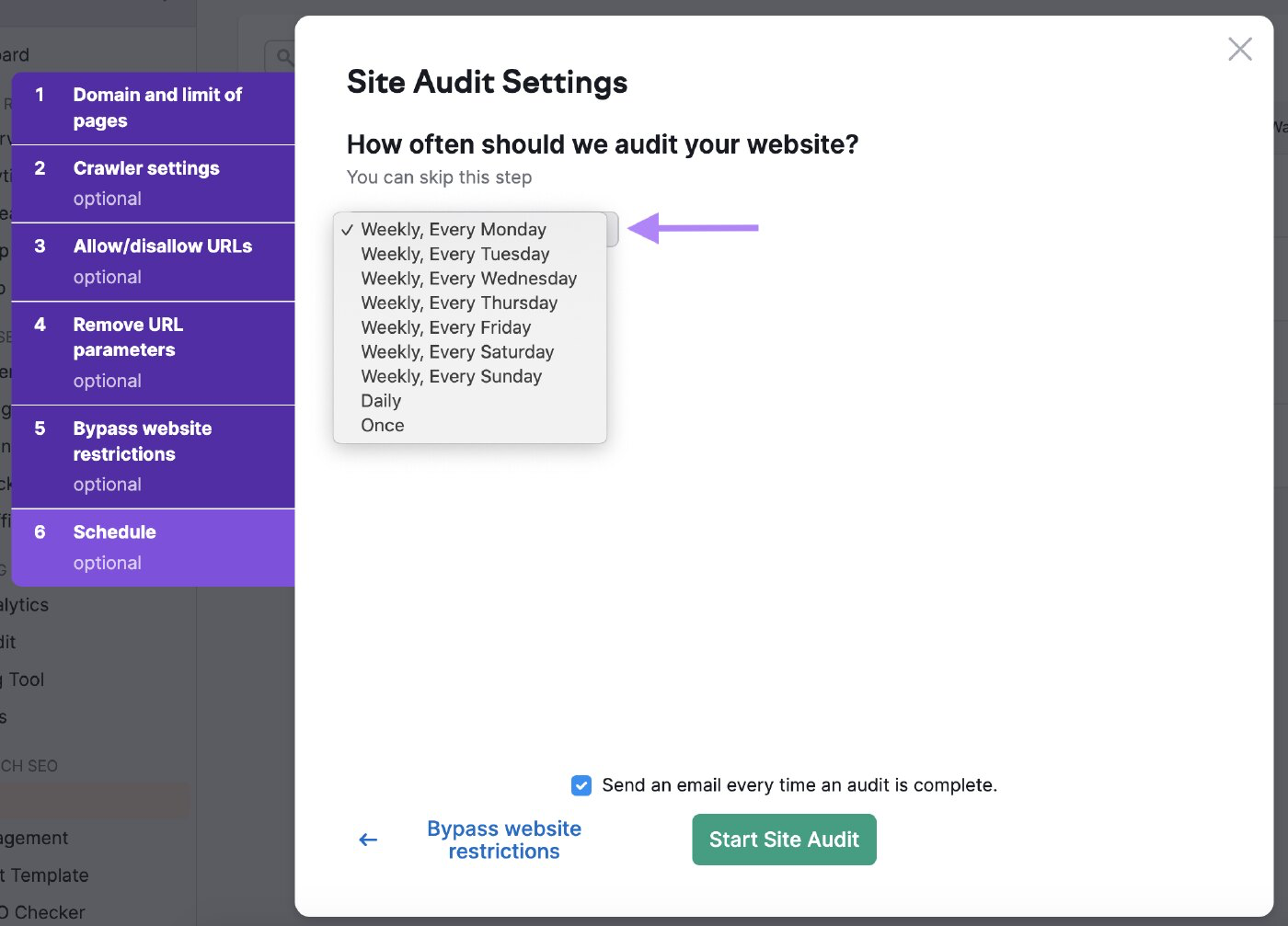

監査のスケジュール

ボットがあなたのウェブサイトを監査する頻度をスケジュールすることができます。

ツールが定期的にウェブサイトの健全性をチェックするよう、頻繁にスケジュールを設定しましょう。

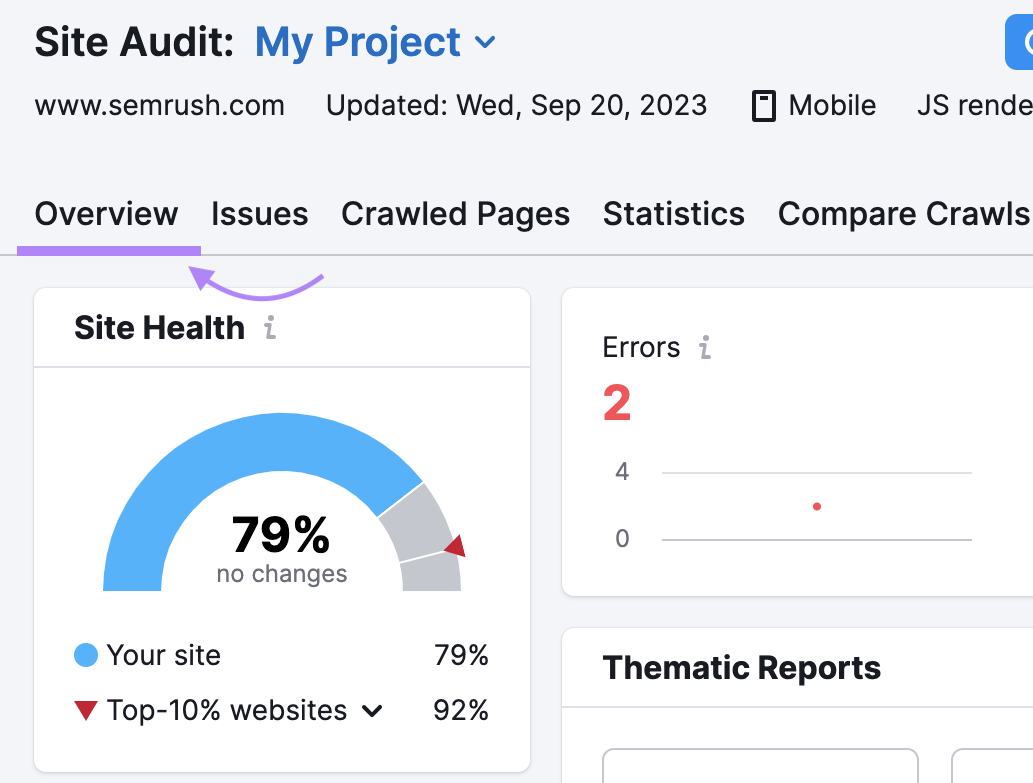

結果を分析する

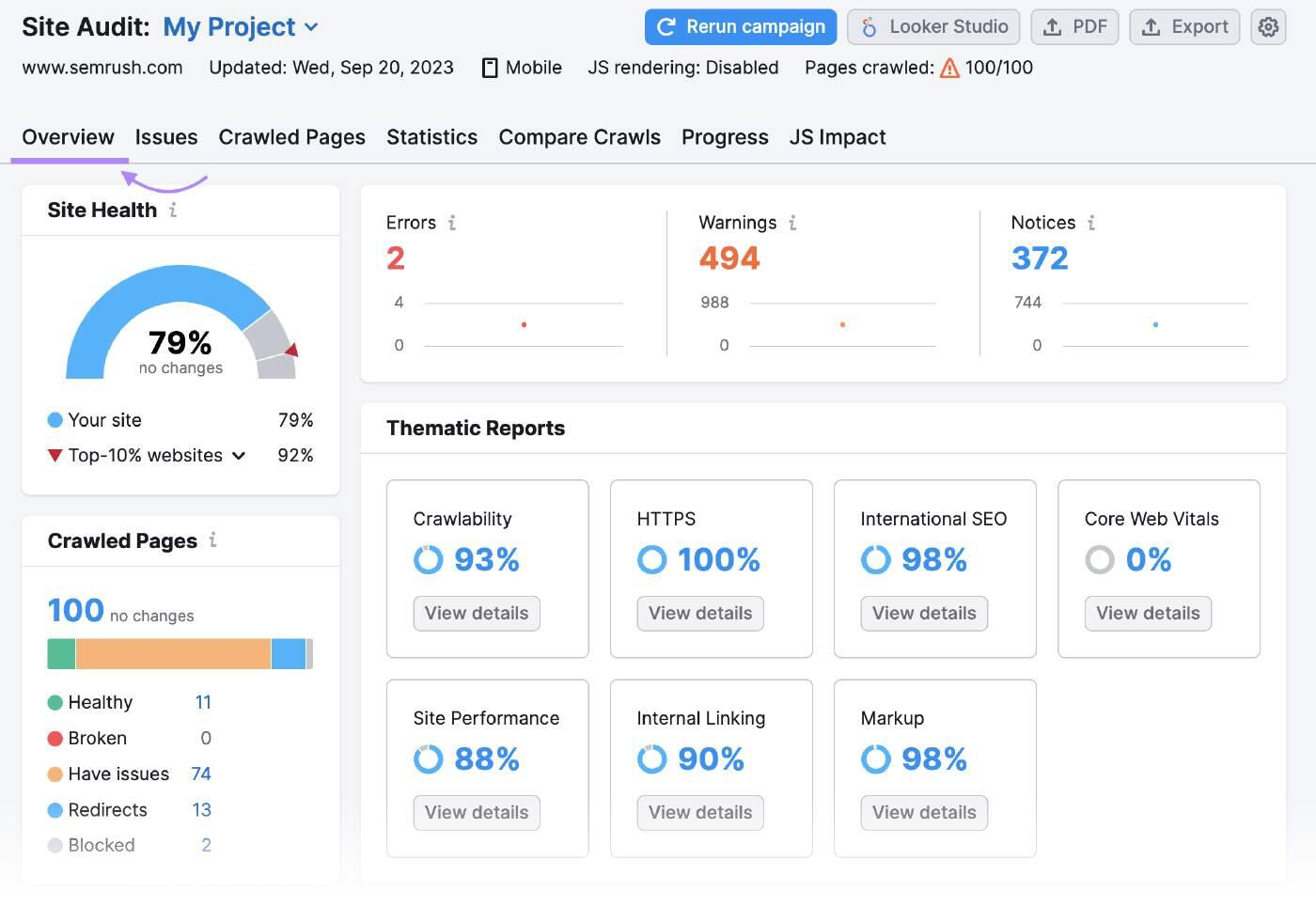

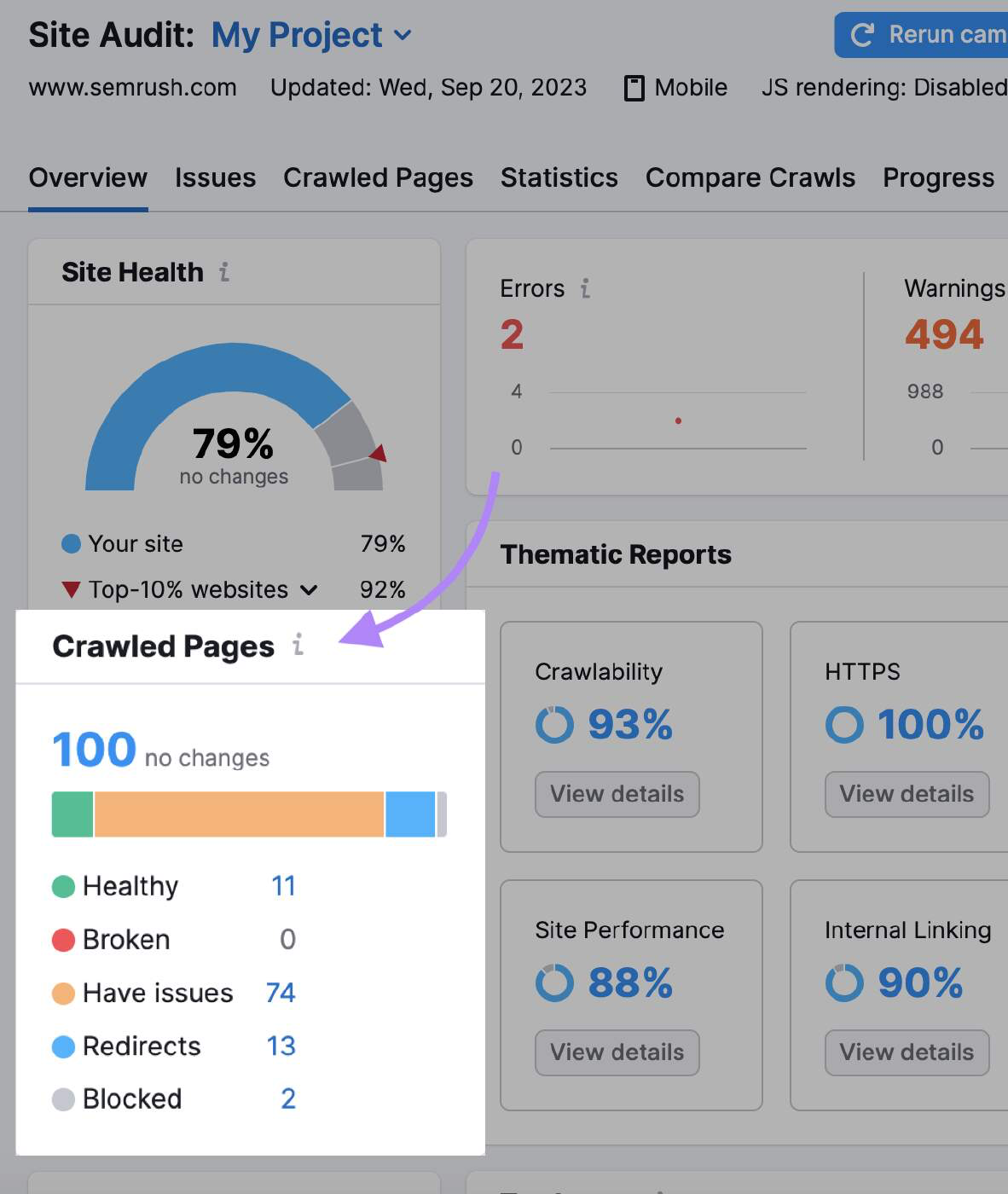

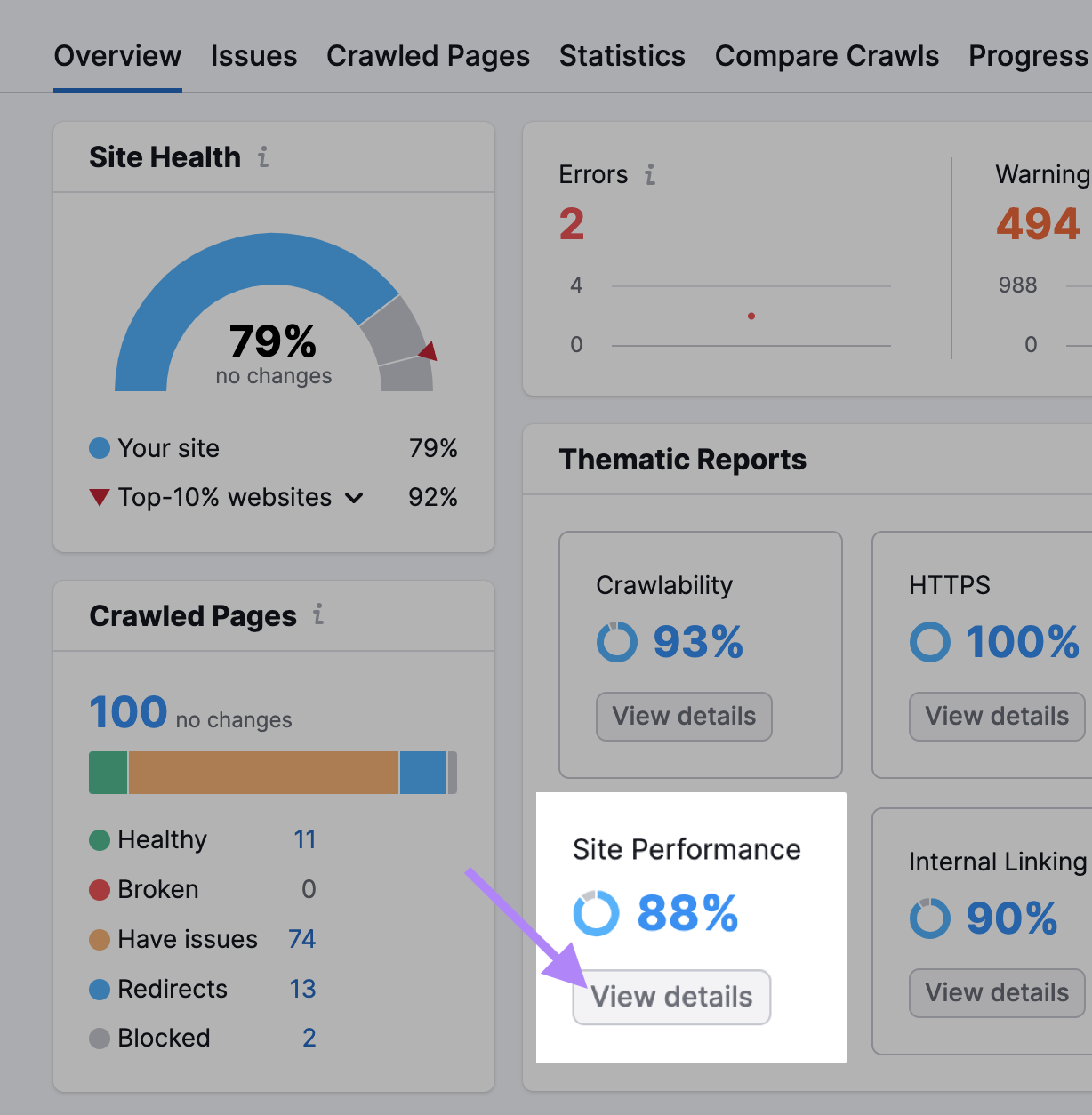

サイト監査の概要には、クロール中にボットが収集したすべてのデータが要約されています。

"クロールされたページ"は、"健全なページ"、"壊れたページ"、"問題があるページ "の数を教えてくれる。

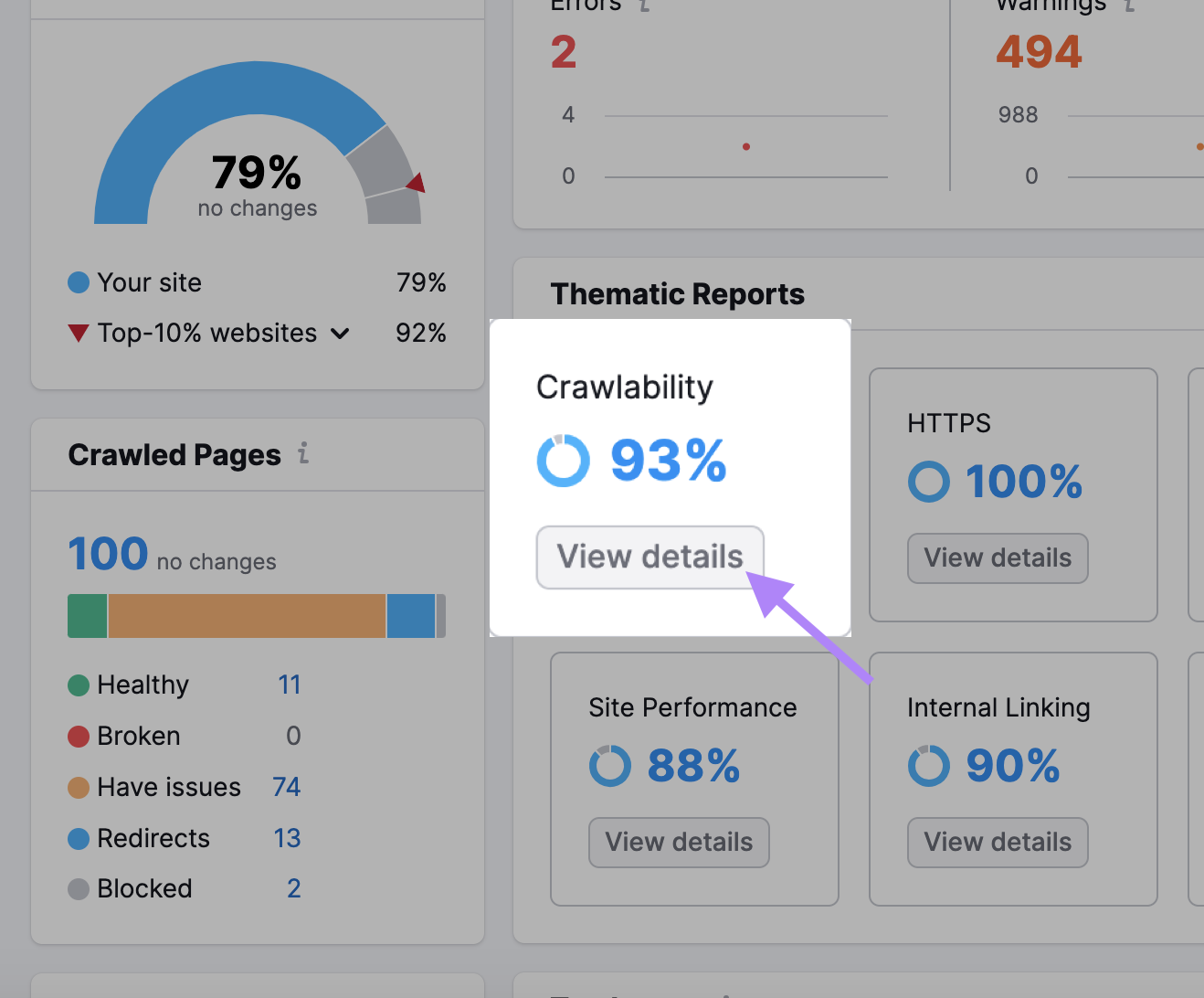

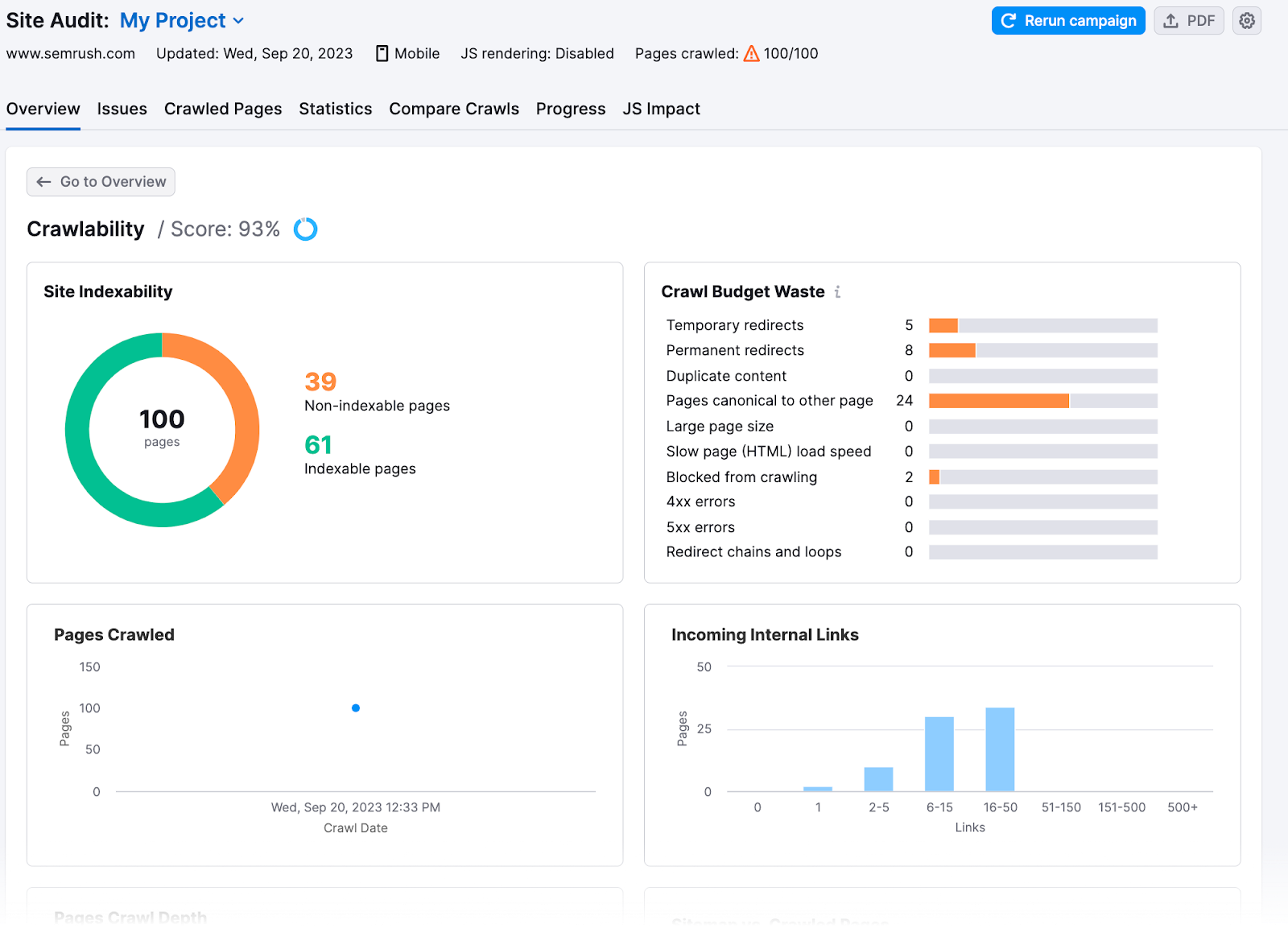

また、「クローラビリティ」セクションでは、より詳細な洞察を得ることができる。

ここでは、あなたのサイトのクロール予算がどれだけ無駄になったか、またはクロール予算に問題があったかがわかります。

SITE AUDIT: [create-campaign destination_url=”https://www.semrush.com/siteaudit/” show_input=”false”header=”Find and Fix Sitemap Errors” text=”with the Site Audit Tool” button_text=”Try for Free”bg_images=”https://static.semrush.com/blog/uploads/media/96/fd/96fd495930d058321d5f78f5554aff88/trial-superbanner-1.png”bg_button=”-success”]

クロール予算最適化のための8つのヒント

サイトの問題がわかれば、それを修正し、クロール効率を最大限に高めることができる。 ここでは、クロール予算を最適化する方法を紹介する:

サイトスピードのチェック

Googleのクロールは、帯域幅、時間、Googlebotリソースの可用性によって制限されます。 ウェブサイトのサーバーがリクエストに素早く対応すれば、グーグルはより多くのページをクロールするかもしれない。

サイトスピードを上げることで、ユーザーエクスペリエンス(UX)を向上させ、Googleがサイトをより速くクロールできるようにします。

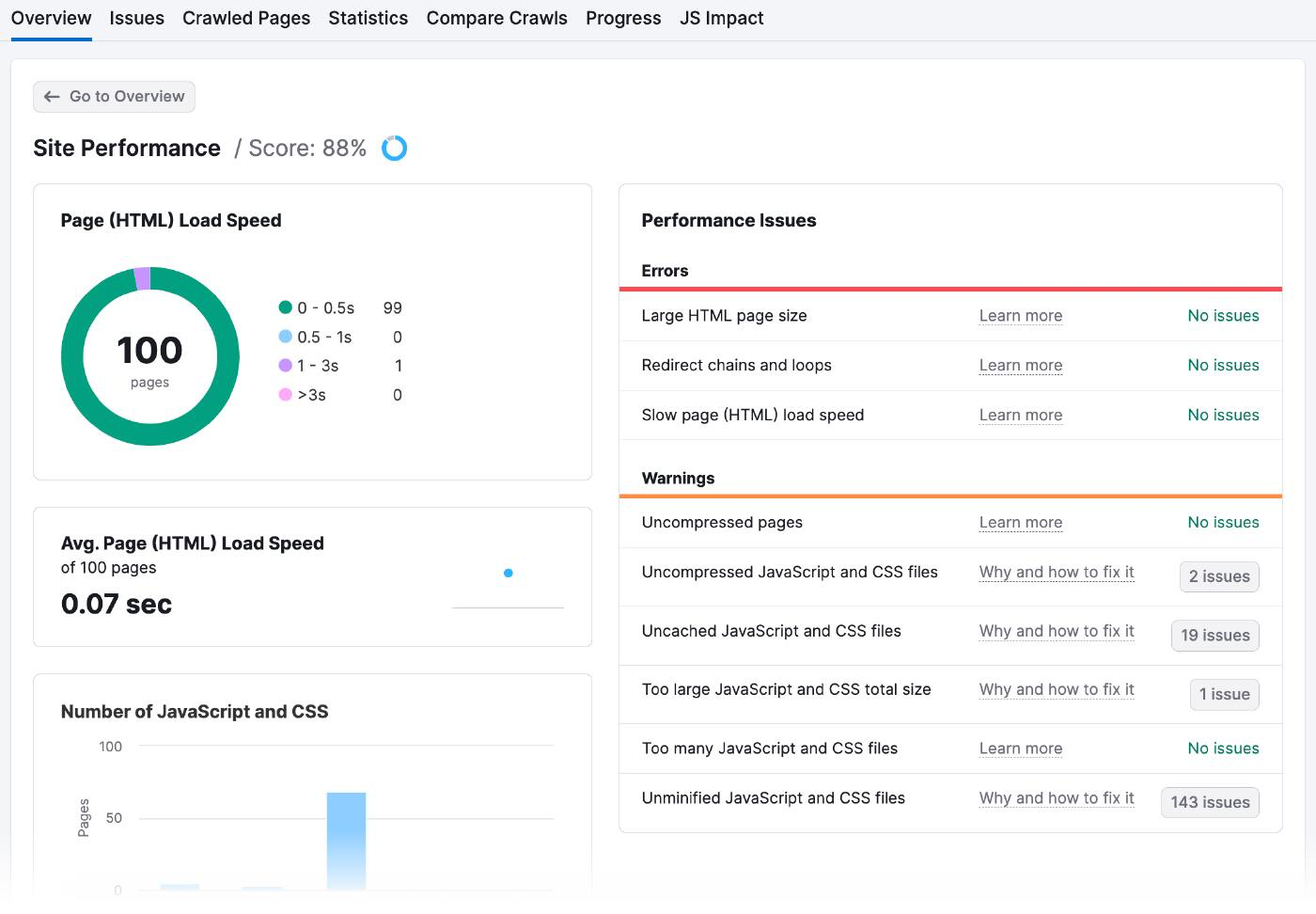

サイト監査の結果をサイトパフォーマンスに移動し、ページのロード時間やパフォーマンスの問題を確認します。

サイト パフォーマンスのページはこんな感じです:

ページ速度を改善する方法はたくさんある:

- 画像を最適化する: Optimizillaのようなオンラインツールを使って、ピクセル化せずにファイルサイズを小さくする。 画像のサイズが適切であることを確認し、適切なファイルタイプ(JPEG、PNG、GIFなど)を選択します。

- コードとスクリプトの最小化ウェブサイトのコードをスキャンして、不要なものや冗長なものを削除する。 また、複数のファイルを1つにまとめ、ブラウザのキャッシュを利用してユーザーのコンピューターにデータを保存し、毎回リロードする必要がないようにする。

- コンテンツ・デリバリー・ネットワーク(CDN)の利用: CDNは、世界のさまざまな場所にあるサーバーのネットワークです。 誰かがあなたのウェブサイトにアクセスしようとすると、CDNは自動的に最も近いサーバーからコンテンツを送信する。 Amazon CloudfrontのようなCDNサービスにサインアップし、そのサーバーにウェブサイトのコンテンツをアップロードし、自分のURLではなくCDNのURLを使うようにウェブサイトを設定する必要がある。

内部リンクとページ・サイトマップを増やす

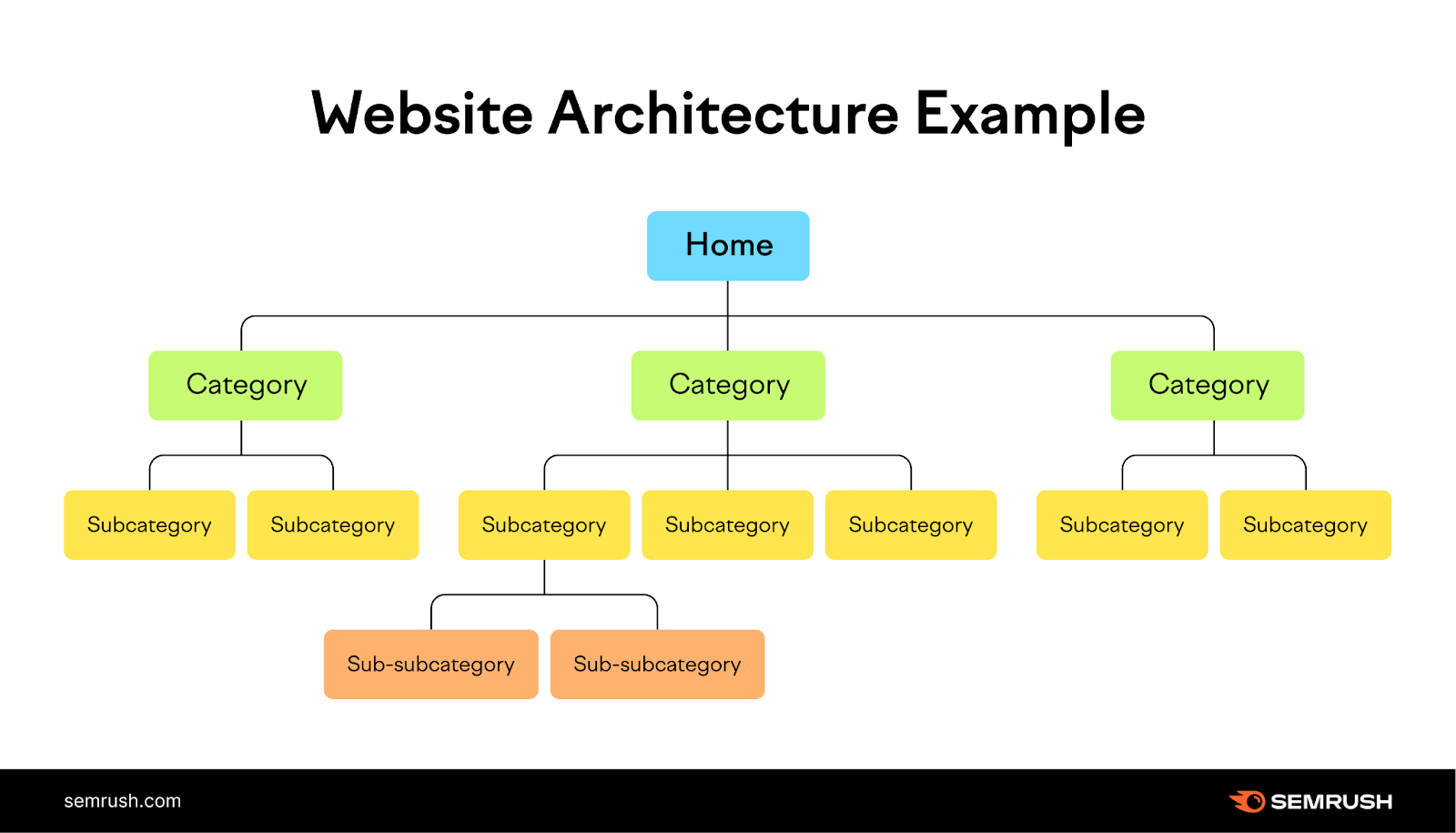

論理的な内部リンク構造とサイトマップを追加することで、ボットにどのページをインデックスさせるかの方向性を与える。

内部リンクは、検索エンジンのクローラーが新しいページを発見してランク付けするための自然な経路を提供し、サイトマップはコンテンツの構造と階層を理解するのに役立ちます。

ウェブサイトをツリーに見立て、トップページを頂点に、さまざまなカテゴリーを枝で表現する。 それぞれの枝は、それに関連する小さな葉(ページ)へとつながり、ユーザーにとってナビゲートしやすい、明確で論理的なウェブサイトの構造を作り出します。

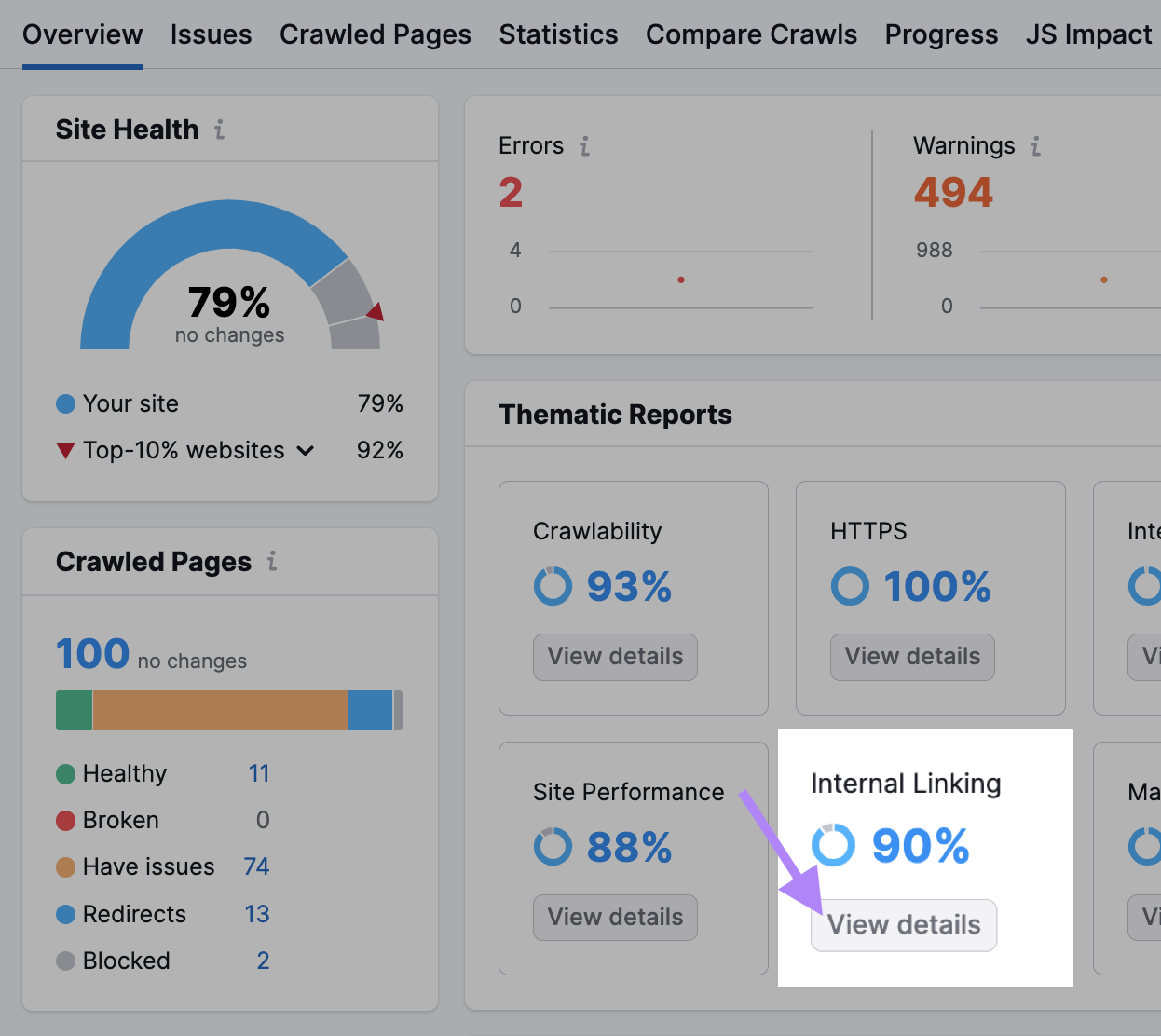

サイトオーディットの 内部リンクセクションをチェックし、どの程度できているかを把握しましょう。

このようなデータが得られたら、内部リンク構造を改善する方法をご紹介しましょう:

- 内部リンク構造のバーは、どのページが強く、平凡で、改善が必要かを教えてくれる。 最後の2つのカテゴリーのページに内部リンクを追加する。

- 関連するページを1つのトピックにまとめ、相互にリンクすることで、トピッククラスターを作成します。 あなたが健康的な生活についてのブログを運営しているとしよう。 メインの柱となるページは "健康的な生活"、トピック・クラスタは "栄養"、"フィットネス"、"メンタルヘルス "といった具合だ。

- Googleは内部リンクがたくさんあるページをクロールする可能性が高い。 問題に直面する可能性があるのは、新しく、十分な内部リンクがないものだ。 例えば、最近「2024年のマーケティング予測」に関する記事を追加したのであれば、グーグルの注目とトラフィックを集めるために、最も重要なページからその記事にリンクを張ります。

検索結果に表示したくないURLを隠す

チェックアウトページ、広告ランディングページ、ログインページ、サンキューページを "noindex "としてマークし、検索エンジンの検索結果に表示されないようにする。 他のmetaタグと同様、「noindex」タグはウェブページの <ヘッド>。

このタグは、重複ページや非公開にしたいページに特に便利です。

ボットはタグを確認するためにこれらのページをクロールするが、彼らは注意し、将来的にクロールを制限する。

検索エンジンに特定のページをインデックスさせないようにするには、「noindex」属性を持つrobotsメタタグを使用する。

以下のタグを、あなたのページの <head> に設置してください:

<meta name="robots" content="noindex">リダイレクトを減らす

リダイレクトは、ボットをあるウェブページから別のウェブページに自動的に送ります。 ボットが移動または削除されたページを訪問した場合、リダイレクトはページの新しい場所、または元のページが利用できなくなった理由を説明するページに移動します。

リダイレクトは、ボットが必要以上に多くのページを訪問するため、より多くのリソースを必要とする。

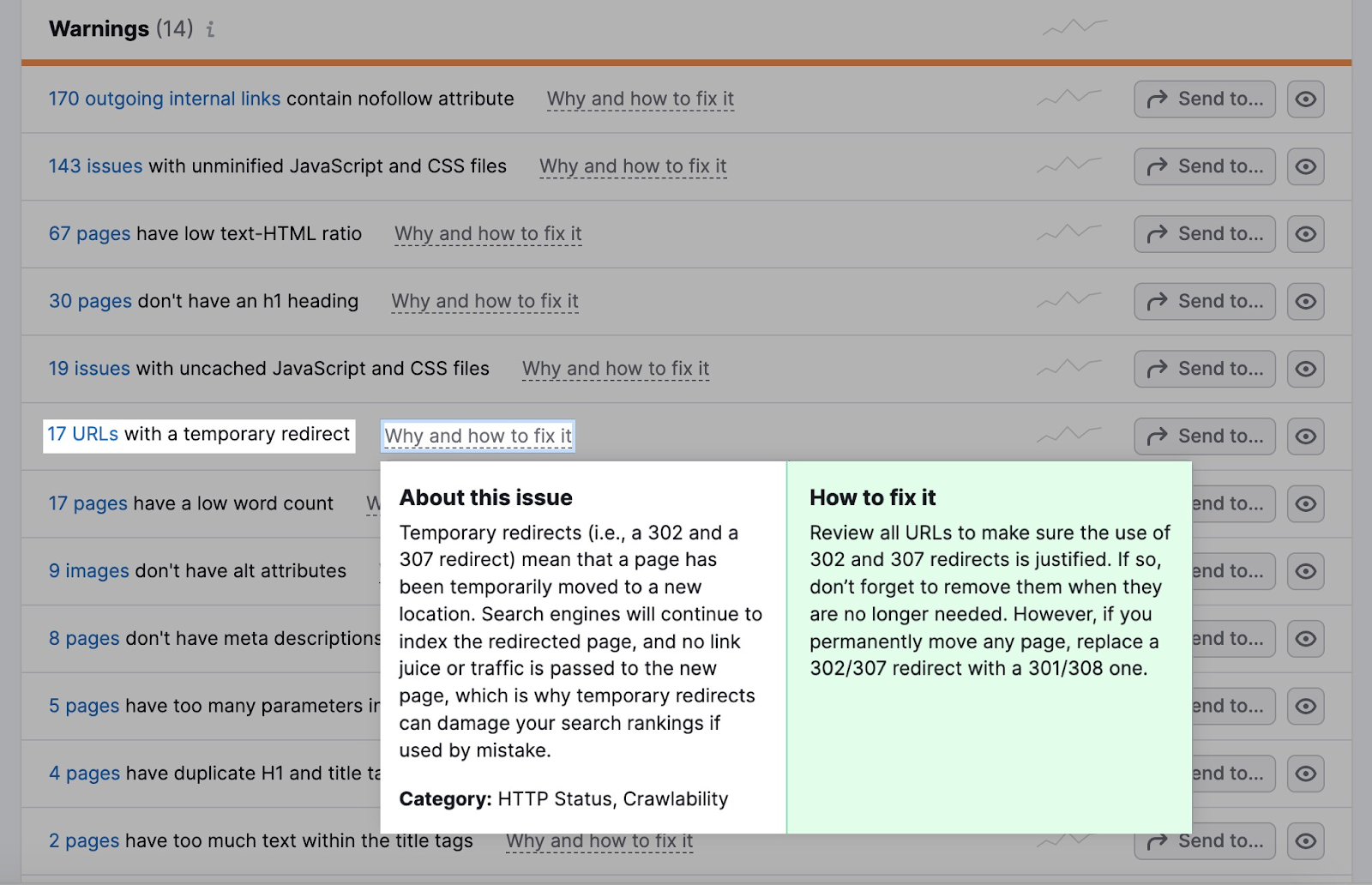

サイトオーディットの[問題]タブに移動します。

警告セクションには、一時的なリダイレクトがあるURLの数が表示されます。

ほとんどのブラウザは、1回のクロールで最大5つのリダイレクトチェーンをたどります。

リダイレクトを使用する場合は、論理的であることを確認してください。

あるスポーツサイトが昨年のフットボールの試合に関する記事を "example.com/football-game-2022 "というURLで掲載しているとしよう。

しかし、今年の試合はURLが違う:"example.com/football-game-2023"。

混乱を避けるため、ウェブサイトは、"example.com/football-game-2022 "にアクセスしようとする人が自動的に "example.com/football-game-2023 "にリダイレクトされるように設定することができる。

このリダイレクトは論理的だろう。

例えば、"example.com/football-game-2022 "から "example.com/football-game-recaps "にリダイレクトし、さらに "example.com/football-game-2023 "にリダイレクトする。

リダイレクトの連鎖が生じ、リソースを浪費し、ウェブサイトのクロール効率に悪影響を及ぼす可能性がある。

リンク切れの修正

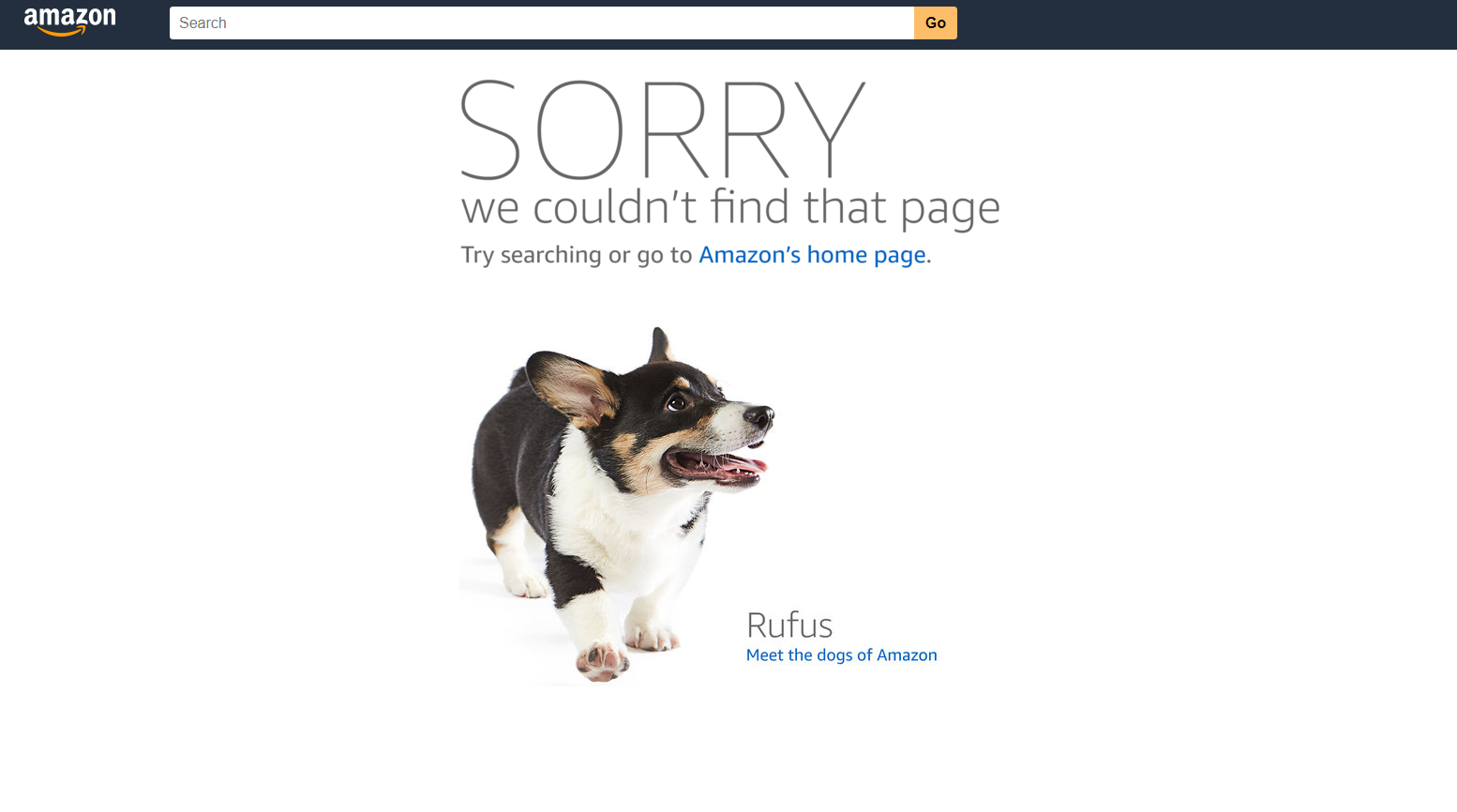

リンク切れとは、ボットがアクセスできないページのこと。 クローラビリティやユーザーエクスペリエンスに悪影響を与える。

ボットがページにアクセスできなければ、クロールもインデックスもできない。 このようなエラーが多すぎると、クロールプロセスが遅くなり、クロールの予算が圧迫される。

たとえば、アマゾンの404エラーはこんな感じだ。

リンク切れは、サイトオーディットの [問題]タブで4xxエラーとして特定できます。

![サイト監査]の[問題]タブでの4xxエラー](https://static.semrush.com/blog/uploads/media/50/d8/50d8f7f1e8882b035211567513ffd309/o9go-Ira2DnHJv_pUFwQdIILx0jr2MdOZogG-dV5PYf0e_jxQsJaVZp56JGeUSkBlSniy8-hPoLh_fnDtYTtYmn0GubGVJPOWnSpsOn3-unGcvtEj6ox5dSeLIqmYiHe57Z_X4WLdJJUCX00t2SoYHk.png)

壊れたページがないかチェックするページ数をクリックします。 そして、壊れたページにつながるすべてのリンクを別のページに置き換える。

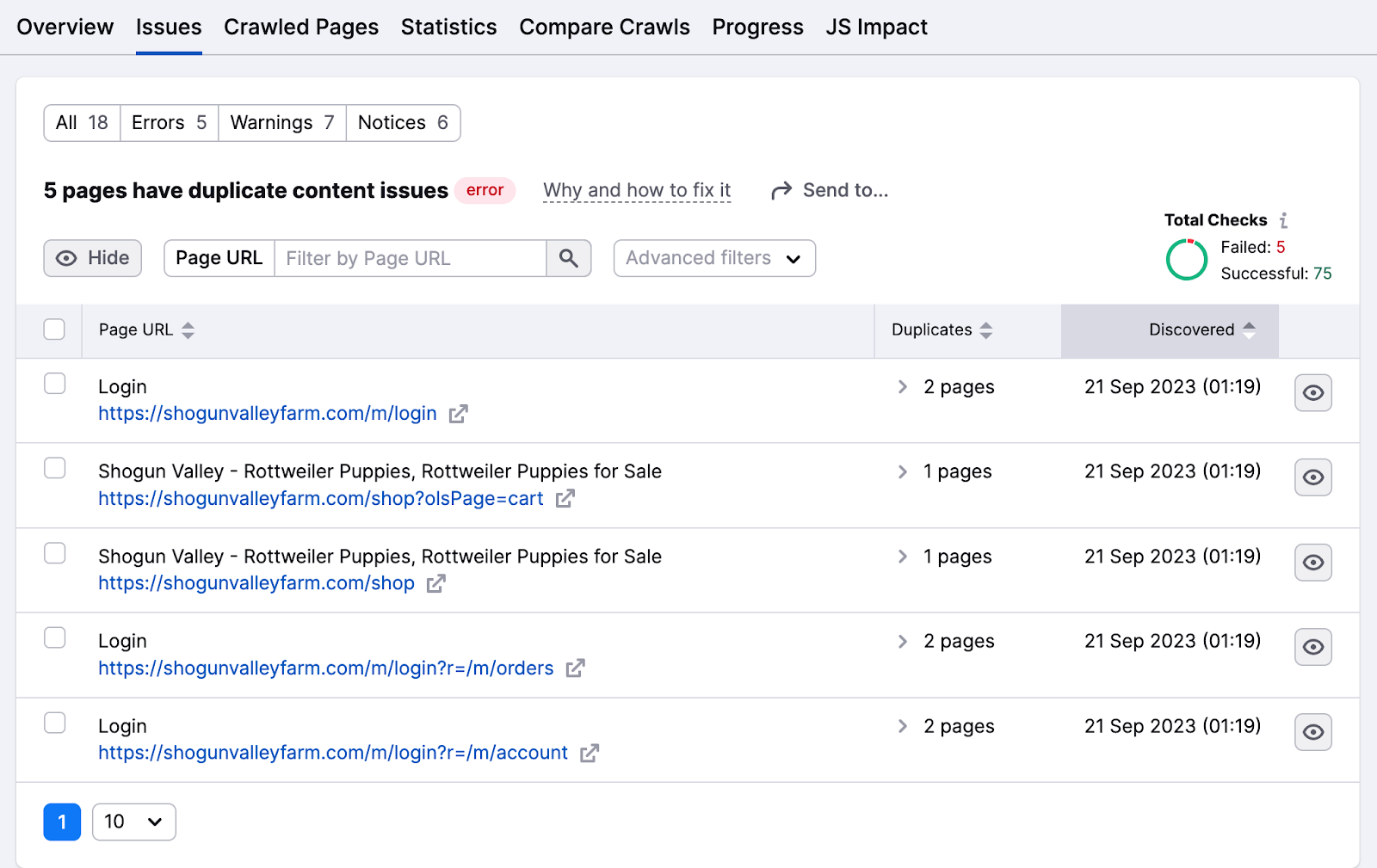

重複コンテンツの排除

ボットは、コンテンツが85%同一であれば、ウェブページが重複していると見なす。 ボットが混乱して同じページを何度もクロールし、時間とリソースを浪費するのを防ぐため、重複コンテンツを減らす。

重複コンテンツは、検索エンジンがそれを操作戦術とみなす可能性があるため、インデックスにも影響する。

問題」タブでは、重複コンテンツの問題がハイライトされます。

![サイト監査]の[問題]タブにおける重複コンテンツ・エラー](https://static.semrush.com/blog/uploads/media/27/31/2731cfedd095e57c436dca6401fb604e/LXC7O7dPcbSO2WvU6EOmJVIpF0WrEPrzUBevDISuoRFiiDefiTGPrPsPL7uZA8kk24lZu3pTmrQGl_cazrHayQV3R5bMKQ94v4Tk3fvoOX8LXAXGW2wSPLXsks-mnRqLVgqZfw0z0KngtOexgHG1pcM.png)

ページ番号をクリックすると、これらの問題があるページのリストを確認できます。

重複コンテンツの問題を解決する方法には、以下のようなものがある:

- トピック・クラスターに編成したり、フォーカス・キーワードを割り当てたりして、コンテンツをユニークなものにする。

- これらのページのHTMLコードにcanonicalタグ"rel=canonical "を追加し、検索結果に表示させたいページをGoogleに知らせる。

- 重複ページからオリジナルページへの301リダイレクトを追加する(リダイレクトを減らすための最良のアイデアではない)

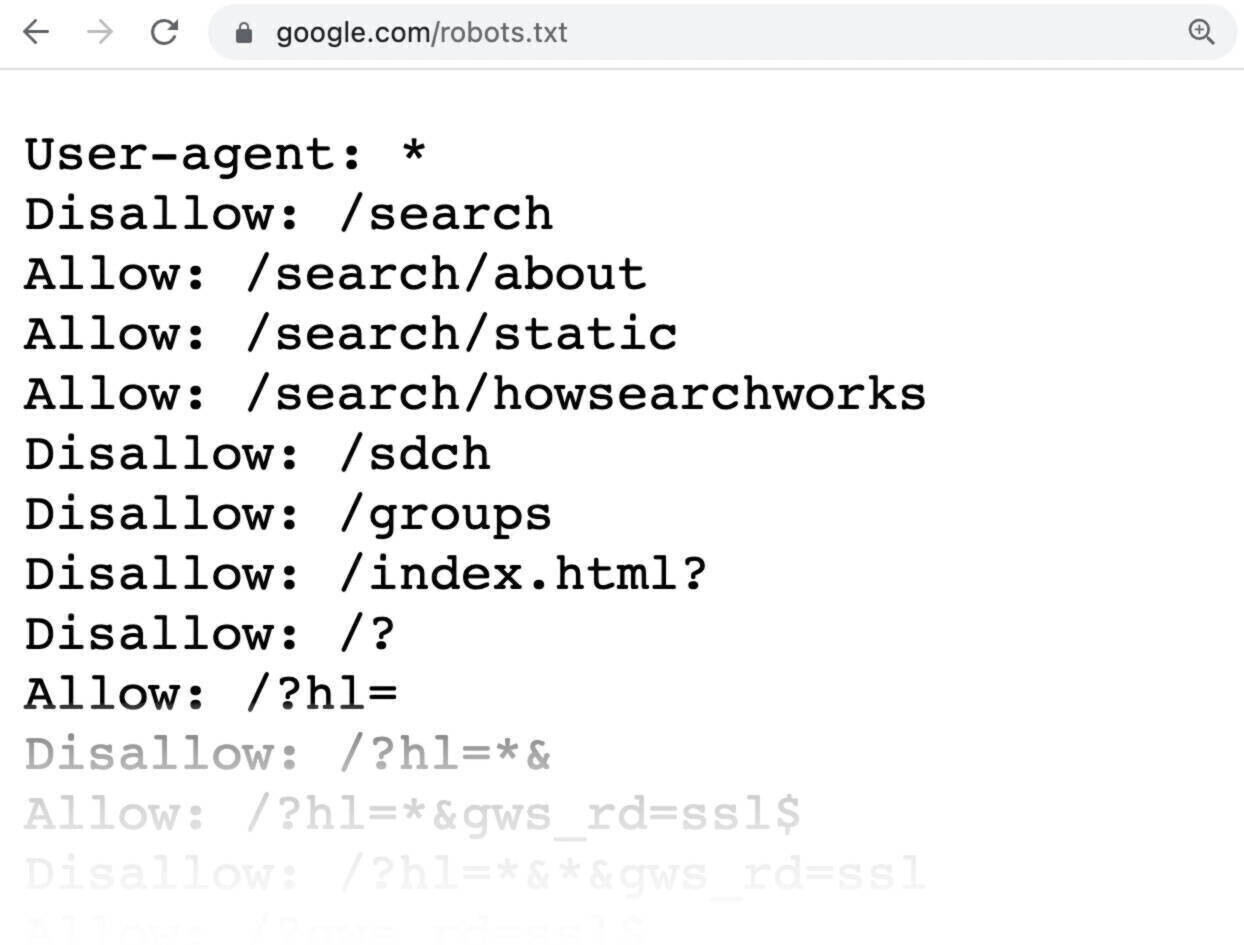

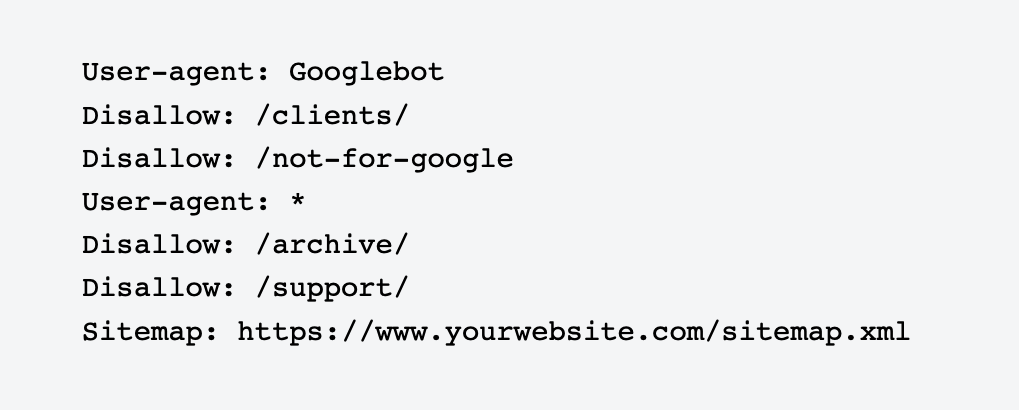

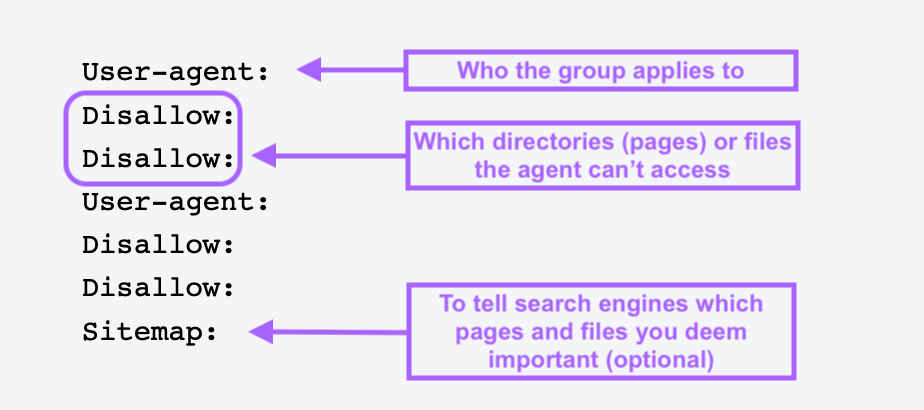

Robots.txtを使用する

robots.txtファイルとは、検索エンジンのボットにクロールやインデックスをさせないページやセクションを知らせるために、ウェブサイトのルートディレクトリに置くテキストファイルです。

Robots.txtファイルは、ログインページのような重要でないページやプライベートなページをブロックするのに役立ちます。 ボットにこれらのページをインデックスさせ、リソースを浪費させたくない。

簡単なrobots.txtファイルはこんな感じです:

インデックスさせたくないページを指定します。

robots.txtファイルを作成するには、robots.txt生成ツールを使用します。 自分で作ることもできる。

まず、任意のテキストエディタまたはウェブブラウザで.txt文書を開き、その文書にrobots.txtという名前を付ける。

次に、ディレクティブ(複数行の命令)を追加する。

robots.txtファイルができたら、保存してサイトにアップロードする。 アップロードのプロセスは、ウェブホスティングとサイトのファイル構造に依存します。

ホスティング・プロバイダーに問い合わせるか、オンラインで検索してください。 例えば、"robots.txt ファイルをShopifyにアップロードする "で検索すると、具体的な手順を得ることができる。

孤児ページを避ける

孤児ページには、内部リンクも外部リンクもありません。 このようなページはクローラーが見つけにくいので、ウェブサイトの他のエリアからリンクすることが重要です。

リストが見つかったら、あなたのウェブサイトの他の権威のあるドメインからこれらのページにリンクを張る。

また、関連するブログ記事、製品ページ、カテゴリーのランディングページをリンクすることで、クローラーが見つけやすくなる。

Semrushでクロール予算を最大化する

Googleは通常、小規模なサイトは簡単にクロールできるが、大規模で複雑なウェブサイトは、検索パフォーマンスを管理するために積極的なアプローチを採用すべきである。

これは、サイトのさまざまな技術的側面を定期的に監視し、最適化することで、アクセスしやすく、構造化され、視認性の高いサイトを維持することを意味する。

ビジネスの規模にかかわらず、Semrushのサイト監査ツールを使用してウェブサイトの健全性を評価し、クローラビリティを最適化し、損害が発生する前にエラーを修正しましょう。 そうすれば、あなたのサイトはSERPで強力なプレーヤーであり続けることができる。

SITE AUDIT: [create-campaign destination_url=”https://www.semrush.com/siteaudit/” show_input=”false”header=”Find and Fix Sitemap Errors” text=”with the Site Audit Tool” button_text=”Try for Free”bg_images=”https://static.semrush.com/blog/uploads/media/96/fd/96fd495930d058321d5f78f5554aff88/trial-superbanner-1.png”bg_button=”-success”]